PyTorch-CUDA-v2.7镜像支持Triton推理服务器,提升服务吞吐

PyTorch-CUDA-v2.7镜像支持Triton推理服务器,提升服务吞吐

在AI模型日益复杂、部署需求不断增长的今天,如何让一个训练好的PyTorch模型真正“跑得快、稳得住、扩得开”,是每个机器学习工程师面临的现实挑战。尤其是在生产环境中,我们常常看到这样的窘境:本地调试完美的模型一上线上就卡顿,GPU利用率始终徘徊在20%以下,高并发时延迟飙升,运维团队疲于应对环境不一致带来的各种“玄学问题”。

有没有一种方式,能让模型服务既保持开发灵活性,又能实现工业级的性能与稳定性?答案正逐渐聚焦于容器化+专用推理引擎的技术组合。其中,PyTorch-CUDA-v2.7 镜像与 NVIDIA Triton 推理服务器的深度集成,正在成为越来越多高性能AI服务架构的核心选择。

这个看似简单的镜像,背后其实融合了从底层驱动到上层服务的全栈优化。它不只是“预装了PyTorch和CUDA”那么简单,而是一个为高吞吐、低延迟推理量身打造的运行时环境。它的真正价值,在于将原本分散、易错的部署链条——驱动配置、依赖管理、GPU调度、批处理逻辑——全部封装成一个可复用、可扩展的标准单元。

容器化推理的演进:从“能跑”到“高效跑”

过去,部署一个PyTorch模型通常意味着手动安装NVIDIA驱动、匹配CUDA版本、编译带CUDA支持的PyTorch,稍有不慎就会遇到libcudart.so not found或version conflict这类令人头疼的问题。即便成功运行,也往往缺乏对动态批处理、多实例并发等高级特性的支持。

通用深度学习镜像(如pytorch/pytorch:latest)虽然简化了部分流程,但它们的设计目标更多是面向训练而非服务。当你试图在这些镜像中运行Triton时,往往会发现缺少必要的LibTorch后端、CUDA上下文管理不完善,或者没有针对推理场景进行内存和线程优化。

而PyTorch-CUDA-v2.7镜像的不同之处在于,它是以服务化部署为第一优先级设计的。它不仅仅是一个运行环境,更是一个推理就绪(inference-ready)平台。通过预集成Triton所需的Python绑定、CUDA工具链(包括cuDNN、cuBLAS、NCCL),以及经过调优的PyTorch CUDA后端,它确保了模型一旦加载,就能立即进入高性能工作状态。

这种“开箱即用”的能力,本质上是一种工程效率的跃迁。开发者不再需要花数小时甚至数天去搭建和验证环境,而是可以直接聚焦于模型本身和服务逻辑。更重要的是,容器化保证了从开发、测试到生产的环境一致性,彻底告别“在我机器上是好的”这类经典难题。

Triton如何释放GPU的最大潜力?

如果说PyTorch-CUDA-v2.7镜像是“肌肉”,那么Triton就是那个懂得如何精准调动每一块肌肉的“神经系统”。传统推理服务通常是“来一个请求,处理一个请求”,这种方式在低并发下尚可接受,但在真实业务场景中,成百上千的请求同时涌入,GPU却经常处于“饥一顿饱一顿”的状态——大部分时间在等待,只有短暂瞬间被充分利用。

Triton的破局之道是动态批处理(Dynamic Batching)。它不会立即执行单个请求,而是将短时间内到达的多个请求自动合并成一个更大的batch,一次性送入GPU进行并行计算。这就像把零散的小包裹整合成一整车货运,显著提升了运输效率。

举个例子:假设你的ResNet-50模型处理单张图像需要8ms,但GPU的计算单元在这8ms内只发挥了30%的算力。如果Triton将16个请求合并成一个batch,总耗时可能只增加到12ms,但单位请求的平均延迟从8ms降到了0.75ms(12/16),吞吐量则提升了近4倍。而这整个过程对客户端完全透明。

除了动态批处理,Triton还提供了多种机制来榨干硬件潜能:

- 多模型并发:你可以在同一块GPU上同时部署图像分类、目标检测、OCR等多个模型,Triton会智能调度资源,避免空闲。

- 模型实例分组(instance_group):可以为同一个模型创建多个实例,分布在不同GPU上,实现负载均衡和容错。

- 自定义后端支持:对于特殊算子或优化需求,可插入自定义C++后端,直接对接底层CUDA kernel。

所有这些功能,都通过一个简洁的config.pbtxt文件进行声明式配置。比如下面这个典型配置:

name: "resnet50"

platform: "pytorch_libtorch"

max_batch_size: 16

input [

{

name: "input__0"

data_type: TYPE_FP32

dims: [ 3, 224, 224 ]

}

]

output [

{

name: "output__0"

data_type: TYPE_FP32

dims: [ 1000 ]

}

]

instance_group [

{

kind: KIND_GPU

count: 1

}

]

dynamic_batching {

max_queue_delay_microseconds: 100000

}

这段配置定义了一个ResNet-50服务:最大支持16的batch size,部署在1块GPU上,并开启动态批处理,最长等待100毫秒以积累足够请求。你可以根据实际QPS和延迟要求,灵活调整max_batch_size和max_queue_delay_microseconds,在吞吐和响应时间之间找到最佳平衡点。

实际落地中的关键考量

当然,理论上的优势要转化为实际收益,还需要关注几个关键实践细节。

首先是模型序列化格式的选择。虽然Triton支持直接加载.pt文件,但在生产环境中,强烈建议使用TorchScript或ONNX导出模型。原因很简单:原始PyTorch模型依赖Python解释器,存在GIL锁、垃圾回收停顿等问题,而TorchScript是独立于Python的序列化格式,执行更稳定、启动更快、内存占用更低。

其次是数据传输效率。当输入数据较大(如高清视频帧)时,频繁的CPU-GPU内存拷贝会成为瓶颈。Triton支持CUDA Shared Memory和System Shared Memory,允许客户端直接将数据写入GPU可访问的内存区域,避免额外复制。在高吞吐场景下,这一优化可带来显著性能提升。

再者是资源监控与弹性伸缩。你可以通过nvidia-smi实时查看显存和GPU利用率,但更推荐结合Prometheus + Grafana构建可视化监控体系。配合Kubernetes的HPA(Horizontal Pod Autoscaler)和Device Plugin,可以根据GPU负载自动扩缩容Triton服务实例,实现真正的弹性推理。

最后别忘了安全与权限控制。在企业环境中运行nvidia-docker通常需要特权模式或特定的安全上下文配置。建议使用非root用户运行容器,并通过RBAC策略限制对Triton管理API的访问权限,防止未授权操作。

从实验室到生产线:一个完整的推理闭环

设想这样一个场景:你在Jupyter Notebook中完成了一个新模型的训练,只需几步即可将其推上生产:

- 使用

torch.jit.script()将模型转为TorchScript; - 将

.pt文件放入/models/resnet50/1/目录; - 编写对应的

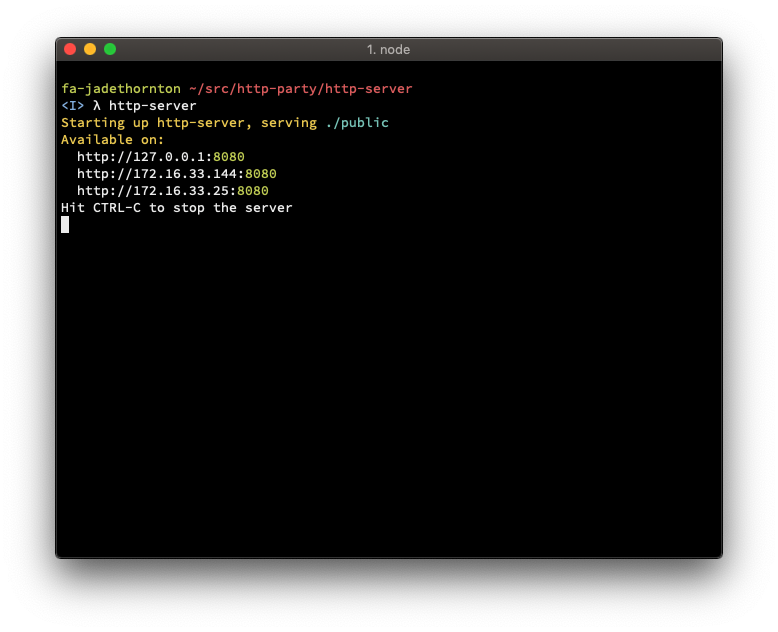

config.pbtxt; - 启动容器:

docker run --gpus=all -v $(pwd)/models:/models pytorch-cuda-v2.7 tritonserver --model-repository=/models; - 通过HTTP/gRPC接口对外提供服务。

整个过程无需重新打包镜像,Triton支持热重载模型配置,更新模型时无需重启服务。这种敏捷性,使得模型迭代周期从“周级”缩短到“小时级”,极大加速了AI产品的交付节奏。

这也正是该方案最深远的意义所在——它不仅提升了单次推理的性能,更重塑了AI工程的工作流。研究人员可以专注于模型创新,而基础设施团队则能通过标准化镜像和自动化编排,保障大规模集群的稳定运行。两者之间的鸿沟,正被像PyTorch-CUDA-v2.7这样的“桥梁”逐步填平。

随着大模型时代的到来,对高效推理的需求只会越来越强。未来的AI系统将不再是孤立的“模型盒子”,而是由多个专业化服务组件构成的复杂网络。在这个背景下,具备高度集成性、可扩展性和性能保障的容器化推理平台,将成为支撑这一切的基石。PyTorch-CUDA-v2.7镜像与Triton的结合,或许只是一个开始,但它清晰地指明了一个方向:让AI服务变得更简单、更强大、更可靠,才是技术落地的最终归宿。