电脑本地docker部署dify,链接autodl服务器中的ollama服务

新手小白,链接服务器端口转发就研究了很久,非常浪费时间

一、vscode链接服务器

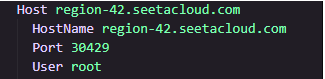

1.我把我总结的方法跟大家简单说说:首先autodl对个人用户是没有公网链接的,所以当你不做端口转发时,你在服务器中运行起来的模型或者说各种前端页面的网址,是无法通过本地网去访问的,

2.所以,我们优先做端口转发,vscode就是一个非常方便的工具,他直接做了端口转发,让你直接在本地可以访问你启动的前端界面、大模型的url路径等等。

3.正常用ssh链接,添加新主机,都在autodl,就是用服务器名称分割成这个格式填进去,输入密码就添加好了,然后链接到服务器

二、打开终端,linux直接curl ollama

1.curl -fsSL https://ollama.com/install.sh | sh

2.ollama serve #安装好之后运行ollama服务

3.ollama run llama2:7b #如未安装会自动开始安装,已有的话会直接运行起来

4.如果安装完成,再次ollama run llama2:7b,此时模型已经启动

5.ollama的端口默认为11434,此时可以通过浏览器访问127.0.0.1.11431

三、本地docker运行dify

我windows系统下载了docker,dify的部署我这边先不讲了,通过docker启动就好,第一次配置时间比较长,可能要10分钟,之后就不需要配置了,每次点开docker就可以启动

1.启动dify之后进入dify的本地网址

[Dify](http://127.0.0.1/apps)

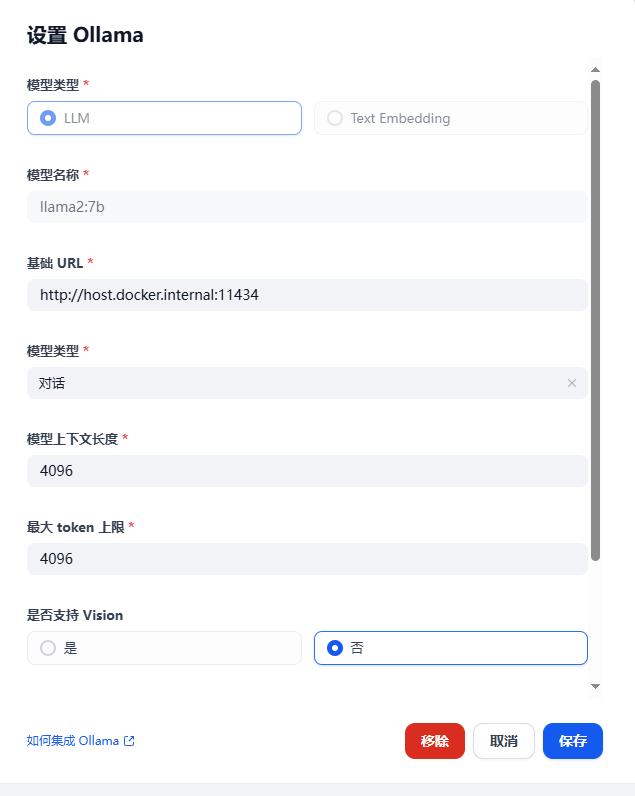

2.进入设置,模型供应商,选择ollama

添加ollama到模型列表后,选择ollama中的添加模型,此时要注意url链接,就是dify能够访问到ollama的地方,因为我的dify再docker中,所以用图片中的url路径,具体可以根据实际情况来。

Integrate Local Models Deployed by Ollama - Dify Docs,这个网址中有ollama的url路径。

添加完成后,在系统模型设置中添加ollama路径中的模型,保存后就可以使用了。

接下来就可以开始探索dify了,搭建个人知识库等,统统拿下!

本文地址:https://www.yitenyun.com/3392.html