第一章:Go静态文件服务器的核心价值与应用场景

在现代Web开发中,静态文件服务器承担着高效分发HTML、CSS、JavaScript、图片等资源的重要职责。Go语言凭借其轻量级并发模型和高性能网络处理能力,成为构建静态文件服务器的理想选择。使用Go内置的

net/http包,开发者可以快速搭建一个稳定、低延迟的静态文件服务,无需依赖外部Web服务器。

为何选择Go构建静态文件服务器

- 内置HTTP支持,无需额外框架即可启动服务

- 高并发处理能力,单机可支撑数万连接

- 编译为单一二进制文件,部署简单且无依赖

- 跨平台兼容,可在Linux、Windows、macOS无缝运行

典型应用场景

| 场景 | 说明 |

|---|

| 前端项目部署 | 托管React、Vue等构建后的静态资源 |

| API文档服务 | 发布Swagger或自定义文档页面 |

| 内部工具平台 | 为运维、测试提供轻量级界面访问 |

基础实现示例

以下代码展示如何使用Go创建一个简单的静态文件服务器:

// main.go

package main

import (

"log"

"net/http"

)

func main() {

// 将当前目录作为文件服务根路径

fs := http.FileServer(http.Dir("./"))

// 路由根路径指向文件服务器

http.Handle("/", fs)

log.Println("服务器启动,监听端口: 8080")

// 启动HTTP服务

err := http.ListenAndServe(":8080", nil)

if err != nil {

log.Fatal("服务启动失败:", err)

}

}

执行

go run main.go后,访问

http://localhost:8080即可浏览当前目录下的文件内容。该实现简洁高效,适用于本地测试或小型生产环境。

第二章:Go语言构建静态服务器的基础原理

2.1 理解net/http包的核心组件与工作流程

Go语言的

net/http 包为构建HTTP服务提供了简洁而强大的接口。其核心由

Handler、

Server 和

Request/Response 三大组件构成。

核心组件解析

Handler 接口定义了处理HTTP请求的方法,任何实现

ServeHTTP(w ResponseWriter, r *Request) 的类型均可作为处理器。

Server 负责监听端口并分发请求到对应的 Handler。

http.HandleFunc("/hello", func(w http.ResponseWriter, r *http.Request) {

fmt.Fprintf(w, "Hello, World!")

})

http.ListenAndServe(":8080", nil)

上述代码注册了一个路由处理器,并启动服务器监听8080端口。匿名函数封装响应逻辑,

w 用于写入响应,

r 携带请求数据。

请求处理流程

当请求到达时,Server 根据注册的路由匹配 Handler,调用其 ServeHTTP 方法完成响应。整个流程通过多路复用器 DefaultServeMux 实现分发,确保高并发下的稳定性能。

2.2 使用http.FileServer提供目录服务的底层机制

文件服务的核心实现

Go语言通过

http.FileServer 快速构建静态文件服务,其底层基于

net/http 包的处理器机制。该函数接收一个

FileSystem 接口实例,返回一个能处理HTTP请求的

Handler。

fs := http.FileServer(http.Dir("./static"))

http.Handle("/public/", http.StripPrefix("/public/", fs))

上述代码将

/public/ 路径映射到本地

./static 目录。

StripPrefix 移除路由前缀,确保文件路径正确解析。

请求处理流程

当收到请求时,

FileServer 调用

Open 方法打开对应文件。若目标为目录,则自动尝试查找

index.html 或返回目录列表(若启用)。

- 请求路径被安全验证,防止路径遍历攻击

- 使用

os.File 打开文件并封装为 http.File - 设置标准MIME类型与响应头

2.3 路由控制与中间件设计在静态服务中的作用

在构建高性能静态文件服务时,路由控制与中间件设计是核心架构要素。合理的路由规则能够精准匹配请求路径,而中间件则提供了一层可复用的逻辑处理机制。

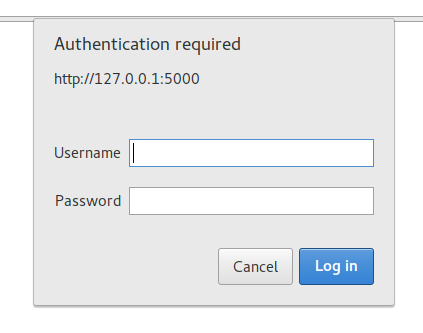

中间件的典型应用场景

常见功能包括日志记录、身份验证、跨域处理和静态资源压缩。通过链式调用,多个中间件可依次处理请求。

基于 Gin 框架的代码实现

func Logger() gin.HandlerFunc {

return func(c *gin.Context) {

start := time.Now()

c.Next()

latency := time.Since(start)

log.Printf("Request: %s | Latency: %v", c.Request.URL.Path, latency)

}

}

该中间件记录每个请求的处理耗时。`c.Next()` 表示继续执行后续处理器,延迟通过 `time.Since` 计算。

路由与静态目录映射

使用

router.Static("/static", "./assets") 可将 `/static` 路径指向本地 `./assets` 目录,实现高效文件服务。

2.4 并发处理模型对比:Go协程如何提升吞吐性能

在传统线程模型中,每个线程通常占用几MB堆栈空间,且上下文切换开销大。相比之下,Go协程(Goroutine)由运行时调度,初始栈仅2KB,支持动态扩缩,成千上万个协程可并发运行于少量操作系统线程之上。

协程启动与调度示例

go func() {

fmt.Println("并发执行任务")

}()

该代码通过

go关键字启动一个协程,函数立即返回,不阻塞主流程。Go运行时的M:N调度器将Goroutine映射到有限线程上,减少系统调用和上下文切换成本。

性能对比

| 模型 | 栈大小 | 切换开销 | 最大并发数 |

|---|

| POSIX线程 | MB级 | 高 | 数千 |

| Go协程 | KB级 | 低 | 百万级 |

2.5 静态资源缓存策略的理论基础与实现方式

静态资源缓存的核心目标是减少重复请求、提升加载速度并降低服务器负载。其理论基础建立在HTTP缓存机制之上,主要包括强缓存与协商缓存两种模式。

强缓存机制

通过响应头中的

Cache-Control 和

Expires 字段控制资源在客户端的缓存时长。例如:

Cache-Control: max-age=31536000, immutable

该配置表示资源可缓存一年,且内容不可变,浏览器无需发起校验请求。

协商缓存

当强缓存失效后,浏览器通过

Last-Modified 或

Etag 与服务器校验资源是否更新。服务器根据

If-None-Match 判断并返回 304 状态码,避免重传。

- Cache-Control 提供更精确的缓存指令

- Etag 能够识别资源细微变化,提高校验精度

第三章:安全机制的设计与落地实践

3.1 HTTPS配置与TLS证书自动化管理实战

在现代Web服务部署中,HTTPS已成为安全通信的基石。正确配置SSL/TLS不仅保障数据传输加密,还能提升用户信任度。

自动化证书获取与更新

使用Let's Encrypt结合Certbot可实现免费证书的自动签发与续期:

certbot certonly --nginx -d example.com --non-interactive --agree-tos -m admin@example.com

该命令通过NGINX插件自动完成域名验证并部署证书,配合cron定时任务实现90天自动续订。

NGINX HTTPS配置示例

server {

listen 443 ssl http2;

server_name example.com;

ssl_certificate /etc/letsencrypt/live/example.com/fullchain.pem;

ssl_certificate_key /etc/letsencrypt/live/example.com/privkey.pem;

ssl_protocols TLSv1.2 TLSv1.3;

ssl_ciphers ECDHE-RSA-AES256-GCM-SHA512;

}

启用TLS 1.2及以上版本,选用前向安全加密套件,提升连接安全性。

| 配置项 | 说明 |

|---|

| ssl_certificate | 公钥证书路径 |

| ssl_certificate_key | 私钥文件路径 |

| ssl_protocols | 启用的安全协议版本 |

3.2 请求限流与防暴力扫描的安全防护方案

在高并发系统中,恶意用户可能通过高频请求发起暴力扫描或DoS攻击。为此,需构建多层次的请求限流机制。

基于令牌桶的限流策略

采用令牌桶算法实现平滑限流,确保突发流量可控:

// Go语言实现令牌桶限流器

type TokenBucket struct {

tokens float64

capacity float64

rate time.Duration // 每秒填充速率

last time.Time

}

func (tb *TokenBucket) Allow() bool {

now := time.Now()

elapsed := now.Sub(tb.last)

tb.tokens += elapsed.Seconds() * tb.rate

if tb.tokens > tb.capacity {

tb.tokens = tb.capacity

}

tb.last = now

if tb.tokens >= 1 {

tb.tokens--

return true

}

return false

}

该实现通过时间差动态补充令牌,

capacity 控制最大并发,

rate 设定填充速度,有效抑制短时高频请求。

IP级访问频率控制

结合Redis记录IP访问频次,设定阈值触发封锁:

- 每IP每分钟请求数超过100次,加入临时黑名单

- 黑名单持续5分钟,期间拒绝服务

- 使用布隆过滤器优化存储效率

3.3 文件访问权限控制与路径遍历漏洞防御

在Web应用中,文件访问权限控制是保障系统安全的核心环节。不当的权限配置或路径处理可能引发路径遍历漏洞,攻击者通过构造`../`等特殊字符访问受限文件。

常见攻击向量示例

../../etc/passwd:尝试读取系统敏感文件%2e%2e%2f:URL编码绕过检测..windowswin.ini:Windows平台路径试探

安全的文件路径校验实现

func safePathJoin(root, path string) (string, error) {

// 清理路径并转换为绝对路径

cleanPath := filepath.Clean("/" + path)

fullPath := filepath.Join(root, cleanPath)

// 确保最终路径不超出根目录

rel, err := filepath.Rel(root, fullPath)

if err != nil || strings.HasPrefix(rel, "..") {

return "", fmt.Errorf("非法路径访问")

}

return fullPath, nil

}

该函数通过

filepath.Clean规范化路径,结合

filepath.Rel验证是否位于根目录内,有效防止路径逃逸。

权限控制建议

| 措施 | 说明 |

|---|

| 最小权限原则 | 服务账户仅拥有必要文件读写权限 |

| 白名单机制 | 限制可访问的目录与文件类型 |

第四章:高性能优化与生产级部署实践

4.1 利用Gzip压缩减少传输体积的实现技巧

在现代Web应用中,减少HTTP响应体大小是提升加载速度的关键。Gzip作为广泛支持的压缩算法,能显著降低文本资源(如HTML、CSS、JS)的传输体积。

服务端启用Gzip的配置示例

以Nginx为例,可通过以下配置开启Gzip压缩:

gzip on;

gzip_types text/plain application/javascript text/css;

gzip_min_length 1024;

gzip_comp_level 6;

上述配置中,

gzip_types指定需压缩的MIME类型,

gzip_min_length避免小文件压缩开销,

gzip_comp_level平衡压缩比与性能。

压缩效果对比

| 资源类型 | 原始大小 | Gzip后大小 | 压缩率 |

|---|

| JavaScript | 300KB | 90KB | 70% |

| CSS | 150KB | 45KB | 70% |

4.2 静态资源ETag与强缓存协同优化策略

在现代Web性能优化中,ETag与强缓存的协同使用能显著降低带宽消耗并提升响应速度。通过设置`Cache-Control`实现强缓存,浏览器可直接使用本地副本;当缓存过期后,结合ETag进行条件请求,服务端仅需对比标识决定是否返回新内容。

典型HTTP响应头配置

Cache-Control: public, max-age=31536000, immutable

ETag: "abc123xyz"

上述配置中,

max-age=31536000表示资源一年内无需重新请求,

immutable告知浏览器内容不会变更,避免重复验证。而

ETag作为资源唯一标识,在缓存失效后用于

If-None-Match比对。

协商流程优势分析

- 减少网络传输:若ETag匹配,返回304状态码,无响应体

- 提高命中精度:相比Last-Modified,ETag可精确反映内容变化

- 兼容CDN:主流CDN节点支持ETag校验机制

4.3 结合Nginx反向代理提升边缘服务能力

在现代边缘计算架构中,Nginx作为高性能的反向代理服务器,能够有效提升服务的响应速度与负载均衡能力。通过将用户请求统一接入Nginx层,可实现对后端多个边缘节点的智能调度。

核心配置示例

upstream edge_nodes {

least_conn;

server 192.168.1.10:8080 weight=3;

server 192.168.1.11:8080 weight=2;

keepalive 32;

}

server {

listen 80;

location /api/ {

proxy_pass http://edge_nodes;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

}

}

上述配置中,

least_conn策略确保新连接被分发到当前连接数最少的节点;

weight参数根据硬件性能分配请求权重;

keepalive维持与后端的长连接,降低握手开销。

优势分析

- 提升边缘服务的高可用性与横向扩展能力

- 通过请求转发隐藏后端拓扑,增强安全性

- 支持动静分离,优化资源加载效率

4.4 容器化部署与Kubernetes编排简化运维成本

容器化技术通过将应用及其依赖打包成轻量级、可移植的镜像,显著提升了部署一致性与环境隔离性。配合 Kubernetes(K8s)这一主流编排平台,企业可实现自动化部署、弹性伸缩与自愈管理。

声明式配置示例

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

replicas: 3

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.25

ports:

- containerPort: 80

该 YAML 定义了一个包含 3 个副本的 Nginx 部署,Kubernetes 自动维持期望状态,降低人工干预频率。

核心优势对比

| 传统部署 | 容器化 + K8s |

|---|

| 环境不一致导致“在我机器上能运行”问题 | 镜像统一,环境一致性高 |

| 扩容需手动配置服务器 | 支持自动水平扩缩容(HPA) |

第五章:从开发到上线——构建可持续演进的静态服务架构

自动化部署流水线设计

在现代前端工程中,CI/CD 是保障快速迭代的核心。通过 GitHub Actions 可实现代码提交后自动构建、测试并部署至 CDN:

name: Deploy Static Site

on:

push:

branches: [main]

jobs:

deploy:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Build

run: npm run build

- name: Upload to S3

run: aws s3 sync dist/ s3://my-static-bucket --delete

资源优化与缓存策略

静态资源应采用内容哈希命名,确保长期缓存安全。例如 Webpack 配置:

module.exports = {

output: {

filename: '[name].[contenthash].js'

}

};

结合 HTTP 缓存头设置:

- HTML 文件:Cache-Control: no-cache

- JS/CSS/图片:Cache-Control: public, max-age=31536000, immutable

多环境配置管理

使用环境变量区分开发、预发与生产配置。例如通过 .env 文件加载:

| 环境 | API 地址 | 日志级别 |

|---|

| development | https://api.dev.example.com | debug |

| production | https://api.example.com | error |

灰度发布与回滚机制

利用 CDN 的版本路由能力,将新版本部署至 /v2/ 路径,通过负载均衡逐步切流。若监测到错误率上升,立即切换回 /v1/ 路径,实现秒级回滚。