服务器IP访问HeyGem系统?http://服务器IP:7860配置指南

服务器IP访问HeyGem系统?http://服务器IP:7860配置指南

在企业级AI视频生成场景中,一个常见痛点浮出水面:如何让多个团队成员高效、稳定地使用同一套数字人生成系统?尤其是在宣传视频批量制作、在线课程录制等任务密集型工作中,单机运行显然无法满足协作需求。这时候,将HeyGem系统部署在一台高性能服务器上,并通过局域网或公网供多人远程访问,就成了最优解。

而实现这一目标的关键一步,正是——通过 http://服务器IP:7860 访问系统。这看似简单的一串地址,背后却涉及Web服务暴露、网络通信机制与运维监控等多个技术环节。若配置不当,轻则“打不开网页”,重则导致服务不可用甚至安全风险。

本文不走寻常路,不堆砌概念,而是以“从启动到可用”的真实工作流为主线,带你穿透 7860 端口背后的完整链路,理解每一步的技术原理与工程取舍。

Web服务是如何“被看见”的?

当你在服务器终端执行 bash start_app.sh 后,屏幕上跳出了熟悉的提示:

Running on local URL: http://127.0.0.1:7860

Running on public URL: http://192.168.31.200:7860

但为什么你在自己电脑的浏览器里输入 http://192.168.31.200:7860 却打不开?问题往往就出在这第一关——服务监听范围。

本地能开,别人打不开?可能是“自我封闭”了

默认情况下,Python Web框架(如Flask或Gradio)只会绑定到 127.0.0.1,也就是所谓的“本地回环地址”。这意味着它只接受来自本机的请求,哪怕你和服务器在同一网络下,也无法从外部连接。

要打破这个限制,必须显式指定监听所有网络接口:

python app.py --host 0.0.0.0 --port 7860

这里的 0.0.0.0 并不是一个真实的IP,而是一个通配符,表示“监听本机所有可用的网络接口”。一旦加上这个参数,你的服务才真正具备“被外界发现”的能力。

💡 实践建议:检查你的

start_app.sh脚本是否包含--host 0.0.0.0。如果没有,请立即补上。否则无论你怎么刷新浏览器,都只是徒劳。

如果你使用的是 Gradio,对应的代码通常是:

demo.launch(server_name="0.0.0.0", server_port=7860)

别小看这一行配置,它是从“个人玩具”迈向“团队工具”的分水岭。

端口为什么是 7860?

你可能会问:为什么偏偏是 7860?能不能换?

其实这是 Gradio 框架的默认端口,选择它的原因很实际:

- 避开常见服务(如80、443、3306),减少冲突;

- 数字易记,适合开发调试;

- 在内网环境中无需特权权限(非1024以下端口)即可运行。

当然,你可以改成 7861、8080 或任意未被占用的端口,只需同步修改启动命令和访问地址即可。但在团队协作中,保持统一端口能极大降低沟通成本。

安全边界在哪里?

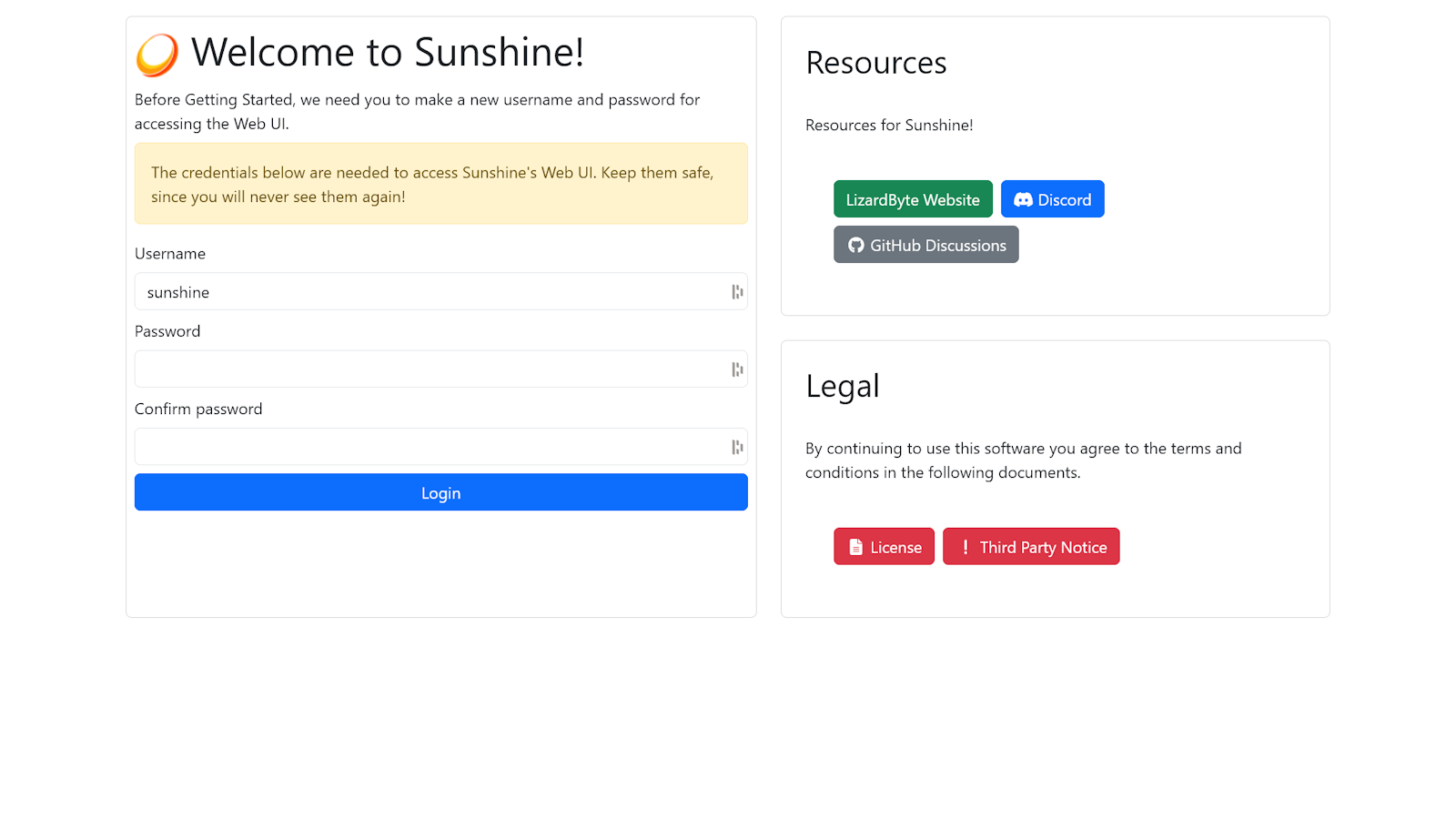

开放 0.0.0.0 意味着任何人都可能尝试连接你。因此,HeyGem 的设计逻辑是:“默认封闭,主动开放”——只有当你明确设置 --host 0.0.0.0 时,系统才对外暴露。这是一种谨慎的安全策略。

但这还不够。真正的防护还需要结合防火墙与身份认证机制。比如,在公网部署时,务必配合 Nginx 做反向代理,并启用 HTTPS 和登录验证,避免敏感模型和数据泄露。

从IP到页面:一次远程访问的旅程

假设你现在坐在办公室的笔记本前,想访问机房里那台装有 HeyGem 的 Ubuntu 服务器。它的局域网 IP 是 192.168.31.200。你在浏览器输入:

http://192.168.31.200:7860

按下回车后,到底发生了什么?

第一步:网络可达性验证

首先,你的电脑必须能“找到”那台服务器。这就要求两者处于同一个子网,或者通过 VLAN、VPN 等方式打通网络。你可以先用 ping 测试连通性:

ping 192.168.31.200

如果超时,说明网络层就不通,后续一切免谈。

第二步:端口是否开放?

即使能 ping 通,也不代表服务可访问。Linux 防火墙(如 ufw 或 firewalld)可能拦截了 7860 端口。

查看当前防火墙状态:

sudo ufw status

若输出中没有 7860/tcp,就需要手动放行:

sudo ufw allow 7860

对于 CentOS/RHEL 系统:

sudo firewall-cmd --add-port=7860/tcp --permanent

sudo firewall-cmd --reload

第三步:云服务器特别注意——安全组!

如果你用的是阿里云、腾讯云或 AWS,还有一个更隐蔽的“守门员”:安全组规则。

这些平台默认会阻止所有入站流量。你需要登录控制台,找到对应实例的安全组设置,添加一条入站规则:

- 协议类型:TCP

- 端口范围:7860

- 源地址:可设为具体IP段(如

192.168.0.0/16),或临时设为0.0.0.0/0(仅限测试)

否则,哪怕本地防火墙全开,外部依然无法连接。

第四步:服务真的在监听吗?

最后确认服务本身是否正常运行。使用以下命令查看端口占用情况:

netstat -tuln | grep 7860

正常应看到类似输出:

tcp 0 0 0.0.0.0:7860 0.0.0.0:* LISTEN

如果是 127.0.0.1:7860,说明仍只监听本地,需重新启动并确保 --host 0.0.0.0 已生效。

日志不是摆设,而是系统的“听诊器”

当一切配置看似正确,但页面依旧加载失败,或者上传文件后毫无反应时,GUI界面往往沉默无言。这时,唯一能告诉你真相的,就是日志。

HeyGem 将运行记录实时写入:

/root/workspace/运行实时日志.log

这是一个纯文本文件,但它承载着整个系统的生命体征。

如何实时“监听”系统心跳?

SSH 登录服务器,打开新终端窗口,执行:

tail -f /root/workspace/运行实时日志.log

这个命令会持续输出文件新增内容,就像医生贴着病人胸口听心跳一样。

当你在浏览器中点击“开始生成”时,应该立刻看到类似日志:

[2025-12-19 14:02:40] INFO: 收到批量生成请求,共3个视频待处理

[2025-12-19 14:02:41] PROCESSING: 正在处理 video1.mp4 [1/3]

[2025-12-19 14:03:15] SUCCESS: 视频生成完成,保存至 outputs/video1_result.mp4

如果有错误,也会清晰呈现:

[2025-12-19 14:04:01] ERROR: CUDA out of memory. Try reducing batch size.

你看,不用进界面、不用截图、不用反复尝试,一条日志就能定位瓶颈。

日志还能怎么用?

-

快速过滤错误:

bash grep "ERROR" /root/workspace/运行实时日志.log -

追踪特定任务:

bash grep "video1.mp4" /root/workspace/运行实时日志.log -

分析性能瓶颈:

统计任务耗时,判断是否需要升级GPU或优化模型加载策略。

更重要的是,日志不会说谎。前端进度条可能卡住,但日志会告诉你后台仍在处理;界面显示“成功”,但日志可能记录了部分失败项——这才是真正的系统可观测性。

实战流程:从零到批量生成数字人视频

让我们把前面所有知识点串联起来,走一遍完整的工程实践流程。

准备阶段

- 确保服务器已安装 Python、PyTorch、CUDA 及相关依赖。

- 克隆项目:

bash git clone https://github.com/yourorg/heygem.git cd heygem - 检查

start_app.sh内容:

bash cat start_app.sh

确认包含:

bash python app.py --host 0.0.0.0 --port 7860

启动服务

bash start_app.sh

观察输出是否包含:

Running on public URL: http://:7860

获取服务器IP

hostname -I

# 或

ip addr show | grep inet

记下形如 192.168.31.200 的地址。

客户端访问

在另一台设备浏览器中输入:

http://192.168.31.200:7860

成功加载页面后:

- 切换至“批量处理模式”

- 拖入音频文件(支持

.wav,.mp3) - 添加多个视频模板(

.mp4,.avi) - 点击“开始批量生成”

监控与排查

另开一个 SSH 终端,运行:

tail -f /root/workspace/运行实时日志.log

观察任务流转状态。若某任务卡住,检查是否有内存溢出、文件路径错误或模型加载失败等问题。

输出管理

生成完成后,视频自动保存至 outputs/ 目录。可通过 Web 界面直接下载,也可在服务器上打包:

zip -r results.zip outputs/

然后通过 SCP 下载到本地:

scp user@192.168.31.200:/path/to/results.zip .

常见问题与应对策略

❌ 打不开网页?试试这四步排查法

| 步骤 | 检查项 | 命令 |

|---|---|---|

| 1 | 服务是否运行 | ps aux | grep python |

| 2 | 是否监听 0.0.0.0:7860 | netstat -tuln | grep 7860 |

| 3 | 防火墙是否放行 | sudo ufw status |

| 4 | 云平台安全组 | 登录控制台检查 |

⚠️ 大文件上传失败?

Gradio 默认有上传大小限制(通常为 1GB)。可在启动时增加参数:

demo.launch(

server_name="0.0.0.0",

server_port=7860,

max_file_size="2gb"

)

同时建议使用局域网传输,避免 WiFi 不稳定导致中断。

🐢 生成速度慢怎么办?

- 查看日志是否有

Using CUDA提示,确认GPU已启用; - 单个视频建议控制在5分钟以内;

- 避免并发提交过多任务,系统采用队列机制顺序处理;

- 对于高频使用场景,可考虑预加载模型、缓存常用音色等方式优化响应速度。

架构背后的设计哲学

HeyGem 看似只是一个Web界面,实则蕴含了典型的前后端分离架构思想:

+------------------+ +----------------------------+

| 用户浏览器 | <---> | HeyGem Web Server (Flask/Gradio) |

+------------------+ +--------------+-------------+

|

+----------------v-----------------+

| AI推理引擎(语音特征提取 + 视频渲染) |

+----------------+------------------+

|

+----------------v------------------+

| 输出目录 outputs/ |

+-------------------------------------+

每一层各司其职:

- 前端:提供直观交互,隐藏复杂性;

- 服务层:承上启下,调度任务;

- 计算层:发挥GPU算力,完成核心推理;

- 存储层:持久化输入输出与日志。

这种设计不仅提升了可维护性,也为未来扩展留下空间——比如加入用户权限系统、任务队列管理、分布式部署等。

写在最后:不止于7860

http://服务器IP:7860 这个地址,表面上只是一个入口,实质上代表着一种能力:将AI能力封装成可共享的服务。

它让一台高性能服务器成为团队的“数字人生产中心”,也让非技术人员能够参与高质量内容创作。而这正是AI工程化的意义所在——不是炫技,而是落地。

当然,这条路还可以走得更远。未来的 HeyGem 可以:

- 加入账号体系,实现多用户隔离;

- 支持 HTTPS,保障传输安全;

- 接入对象存储(如 MinIO、S3),摆脱本地磁盘限制;

- 引入 Celery 等任务队列,提升并发处理能力。

但无论功能如何演进,理解 7860 端口背后的网络、服务与日志机制,始终是驾驭这套系统的基石。毕竟,再智能的系统,也离不开扎实的工程底座。