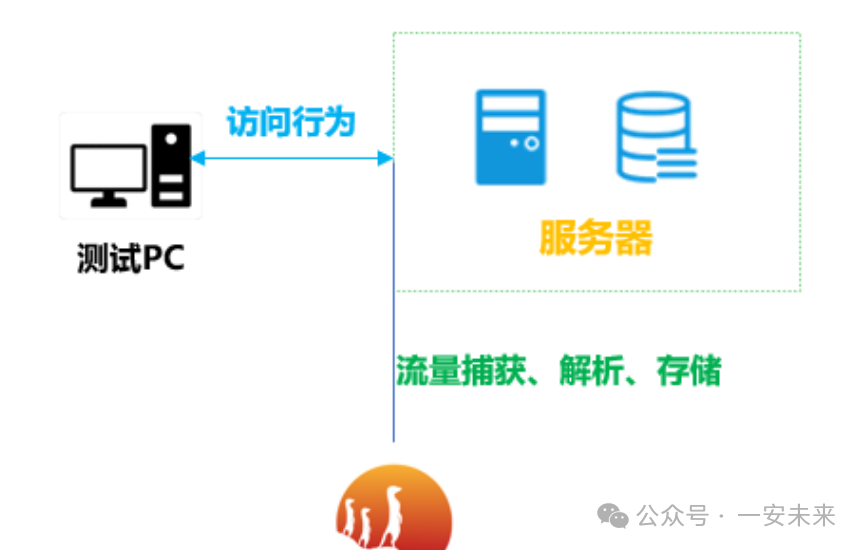

如何将实时流量解析并存入数据库

Suricata介绍

Suricata是一个开源的网络入侵检测和防护系统(IDS/IPS),由Open Information Security Foundation(OISF)开发和维护。该系统可以利用多线程设计在硬件上实现高性能数据处理,并且能够深入检查并解析多种网络和应用层协议。通过高级的流量处理和还原能力,Suricata能够实时识别并处理网络威胁,为分析人员提供原始且详尽的网络通信数据,助其深入洞察网络行为,预防潜在的安全隐患。

流量还原技术的原理

Suricata流量还原技术主要基于网络流量来重构原始数据,为深入分析和研究数据提供基础。一旦Suricata捕获到网络流量,就能灵活解析多种协议,并从中提取文件、会话内容等关键数据。流量还原技术的核心在于,它将这些提取的数据按照原始的顺序和结构重新排序,确保还原出的数据与原始传输状态一致。这种技术赋予了分析人员直观理解攻击内容、方法和目的的能力,并为后续的高级分析(如文件的恶意性检测)提供了有力支持。

(1)数据包捕获

首先,Suricata通过监听指定的网络接口,利用如PCAP这样的工具库,实时捕获并临时存储数据包。为了保障数据的完整性以及检测的准确性,Suricata通过特定的内存和缓冲区策略,确保即使在高流量环境下也能有效捕获数据。同时,通过动态的负载均衡技术,Suricata使得每个处理线程都能有效处理其分配到的数据,从而提高处理效率,防止性能瓶颈出现。

(2)会话跟踪

会话跟踪是确保网络流量上下文完整性的关键环节。一旦Suricata识别到一系列相关联的数据包,它会依据源、目标地址及端口信息快速创建会话记录。这些记录不仅用于分类,更是为了全面理解通信的完整性。为了高效管理这些会话,Suricata维护了一个动态的会话表,能够迅速识别并更新现有会话或创建新会话。此外,通过对会话内的数据包进行深度分析,Suricata能够捕捉更为复杂的通信模式(如多阶段攻击或数据传输),从而为后续的安全分析和响应提供详尽且丰富的上下文信息。

(3)数据包排序

数据包在传输过程中可能会遭遇乱序,因此排序成为流量重组的重要环节。在TCP通信中,Suricata精准利用TCP头部的序列号来确定数据包的正确顺序,确保每个数据包都能各归其位。

数据包排序关乎流量的连贯性、数据的完整性和准确性,而网络拥塞、路由变动或其他外部因素都可能导致数据包顺序混乱,进而影响数据流的完整性和分析结果的准确性。为此,Suricata通过持续跟踪每个会话的状态和预期的数据包序列号,对这些数据包进行排序。此外,为了确保不会因为失序而丢失重要的通信内容,Suricata会暂时存储那些尚未找到正确位置的数据包。这一策略在保障数据流完整性的同时,也确保了Suricata在处理高速、高流量网络时,能够捕获并正确解析所有关键信息,为网络安全分析提供强有力的支持。

(4)重组数据流

当数据包经过精确的排序后,Suricata便开始着手将这些分散的碎片重新拼凑成原始的形态。像拼图一样,每个数据包都被放在其应有的位置,形成一个流畅且连贯的数据流。这一过程不仅还原了通信的真实情境,也为后续深入的安全分析构建了稳固的基石。

(5)处理重组的数据

数据流一经Suricata恢复与重组,便开启了对数据的深入挖掘之旅。这一过程不仅仅是简单的内容浏览,而是涵盖了多层次、多角度的细致分析,包括但不限于协议分析、应用行为识别,以及潜在安全威胁检测等。

(6)协议解析

协议解析是流量重组后的首要任务。Suricata凭借内置的协议解析器,能够轻松解码网络中遵循的多种协议,如HTTP、FTP、SMTP等。这一解码过程不仅有助于识别数据流的类型,也有助于进一步的数据提取。

(7)数据提取

在协议解析的基础上,Suricata能够进一步从数据流中提取关键信息和内容,涵盖特定字符串、用户凭据、URL乃至完整的文件内容。这些提取出的数据元素可用于进一步的分析,例如与恶意软件签名匹配或进行行为分析,并为数据重组工作提供支持。

如何使用

安装过程略过,网上教程也有很多,这里不再赘述

配置suricata

编辑配置文件/etc/suricata/suricata.yaml

# 指定监听的网卡(如 eth0)

af-packet:

- interface: eth0

# 启用HTTP协议解析

app-layer:

protocols:

http:

enabled: yes

# 配置EVE日志输出(JSON格式)

outputs:

- eve-log:

enabled: yes

filetype: regular

filename: eve.json

types:

- http:

extended: yes # 启用扩展字段

request-body: yes # 记录请求体(可选)

response-body: yes # 记录响应体(可选)配置完成以后,我们在eth0制造一些流量,就可以看到suricata对实时流量进行了解析:

UDP

{

"timestamp": "2025-04-25T11:20:45.678901+0800",

"flow_id": 987654321098765,

"event_type": "flow",

"src_ip": "172.16.0.20",

"src_port": 33333,

"dest_ip": "192.168.2.200",

"dest_port": 53,

"proto": "UDP",

"app_proto": "dns",

"flow": {

"pkts_to_server": 2,

"pkts_to_client": 2,

"bytes_to_server": 100,

"bytes_to_client": 100

},

"start": "2025-04-25T11:20:00.000000+0800",

"end": "2025-04-25T11:20:50.000000+0800",

"age": 50,

"state": "established",

"reason": "timeout",

"alerted": false

}TCP

{

"timestamp": "2025-04-25T12:30:10.345678+0800",

"flow_id": 567890123456789,

"event_type": "flow",

"src_ip": "192.168.3.15",

"src_port": 8888,

"dest_ip": "10.1.1.10",

"dest_port": 22,

"proto": "TCP",

"app_proto": "ssh",

"flow": {

"pkts_to_server": 10,

"pkts_to_client": 8,

"bytes_to_server": 500,

"bytes_to_client": 400

},

"start": "2025-04-25T12:29:30.000000+0800",

"end": "2025-04-25T12:30:20.000000+0800",

"age": 50,

"state": "established",

"reason": "user_logout",

"alerted": false

}HTTP

{

"timestamp": "2025-05-01T10:15:40.789012+0800",

"flow_id": 864209753108624,

"event_type": "http",

"src_ip": "192.168.20.30",

"src_port": 53002,

"dest_ip": "172.67.147.133",

"dest_port": 8080,

"proto": "TCP",

"app_proto": "http",

"http": {

"http_method": "POST",

"url": "/api/login",

"protocol": "HTTP/1.1",

"status": 200,

"length": 567,

"http_user_agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 13_3_1) AppleWebKit/605.1.15 (KHTML, like Gecko) Version/16.4 Safari/605.1.15",

"post_data": "username=testuser&password=testpass"

},

"start": "2025-05-01T10:15:20.000000+0800",

"end": "2025-05-01T10:15:50.000000+0800",

"age": 30,

"state": "completed",

"reason": "normal",

"alerted": false

}解析入库

以HTTP为例,创建表结构

-- 创建存储 HTTP 流量解析信息的表

CREATE TABLE http_traffic_analysis (

-- 流量记录的唯一 ID,自增主键

id INT AUTO_INCREMENT PRIMARY KEY,

-- 事件发生的时间戳

timestamp DATETIME NOT NULL,

-- 流量的唯一标识符

flow_id BIGINT NOT NULL,

-- 事件类型,固定为 'http'

event_type VARCHAR(20) NOT NULL DEFAULT 'http',

-- 源 IP 地址

src_ip VARCHAR(45) NOT NULL,

-- 源端口号

src_port INT NOT NULL,

-- 目的 IP 地址

dest_ip VARCHAR(45) NOT NULL,

-- 目的端口号

dest_port INT NOT NULL,

-- 传输层协议,如 TCP、UDP

proto VARCHAR(10) NOT NULL,

-- 应用层协议,固定为 'http'

app_proto VARCHAR(20) NOT NULL DEFAULT 'http',

-- HTTP 请求方法,如 GET、POST

http_method VARCHAR(10) NOT NULL,

-- HTTP 请求的 URL

http_url VARCHAR(2048) NOT NULL,

-- HTTP 协议版本,如 HTTP/1.1

http_version VARCHAR(10) NOT NULL,

-- HTTP 响应状态码,如 200、404

http_status_code INT NOT NULL,

-- HTTP 响应的长度

http_response_length INT,

-- 客户端的用户代理信息

http_user_agent VARCHAR(255),

-- HTTP POST 请求的数据

http_post_data TEXT,

-- 连接开始时间

start_time DATETIME NOT NULL,

-- 连接结束时间

end_time DATETIME NOT NULL,

-- 连接持续时间

age INT NOT NULL,

-- 连接状态,如 completed

state VARCHAR(20) NOT NULL,

-- 事件原因,如 normal、page_not_found

reason VARCHAR(50),

-- 是否触发警报

alerted BOOLEAN NOT NULL DEFAULT FALSE

);读取Suricata的EVE日志文件,并将数据存储到MySQL数据库中

public class SuricataDataStorage {

private static final String DB_URL = "jdbc:mysql://localhost:3306/suricata_data";

private static final String DB_USER = "your_username";

private static final String DB_PASSWORD = "your_password";

public static void main(String[] args) {

try (Connection connection = DriverManager.getConnection(DB_URL, DB_USER, DB_PASSWORD);

BufferedReader reader = new BufferedReader(new FileReader("/var/log/suricata/eve.json"))) {

String line;

while ((line = reader.readLine()) != null) {

try {

JSONObject event = new JSONObject(line);

//TODO 写入数据库

} catch (Exception e) {

System.err.println("Error parsing JSON line: " + e.getMessage());

}

}

} catch (SQLException e) {

System.err.println("Database connection error: " + e.getMessage());

} catch (IOException e) {

System.err.println("File reading error: " + e.getMessage());

}

}

}以上代码只是一个简单的示例,实际应用中可能需要根据具体需求进行修改和扩展。