服务器内存:数字世界的“记忆中枢”与性能基石

目录

一、内存的基础功能

二、技术演进

三、内存性能对服务器的影响

四、内存优化策略

五、未来展望

结语

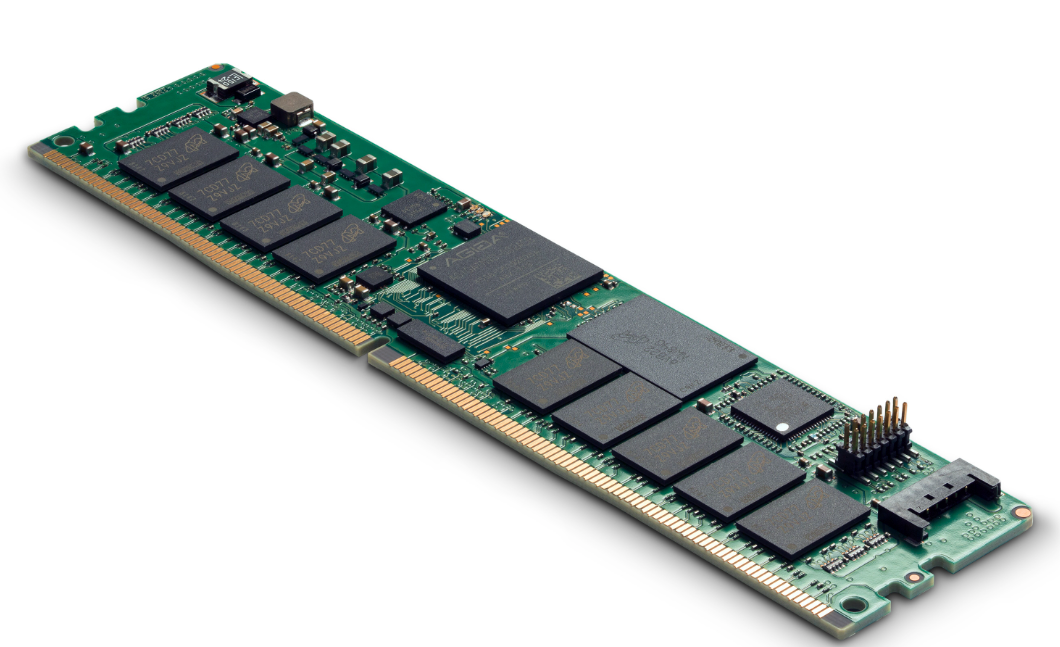

在数字化浪潮席卷全球的今天,服务器作为数据存储、处理与传输的核心枢纽,支撑着从云计算到人工智能的各类应用。而内存(RAM,Random Access Memory)作为服务器的“短期记忆库”,其性能与可靠性直接影响着系统的整体效率。本文将从内存的基础功能、技术演进、性能影响及优化策略四个维度,全面解析服务器内存的核心作用。

一、内存的基础功能

服务器内存的本质是高速随机存取存储器,其核心价值在于为CPU提供快速读写数据的临时空间。与硬盘、固态硬盘(SSD)等长期存储设备不同,内存具有以下特性:

- 高速存取:内存的读写速度可达纳秒级(10⁻⁹秒),远超硬盘的毫秒级(10⁻³秒),能实时响应CPU的指令需求。

- 易失性存储:断电后内存数据会丢失,但其临时存储特性使其成为处理动态数据的理想场所。

- 直接交互:CPU通过内存总线直接访问内存中的数据,避免因频繁读取硬盘导致的性能瓶颈。

典型应用场景:

- 数据库查询:当用户发起查询请求时,服务器需从硬盘加载数据至内存,再由CPU处理。内存容量不足会导致频繁的硬盘I/O操作,显著降低响应速度。

- 虚拟化环境:在虚拟机(VM)中,内存需同时承载多个操作系统的运行数据,其分配效率直接影响虚拟机的性能隔离与资源利用率。

- 大数据分析:内存计算框架(如Apache Spark)将数据缓存至内存,通过并行处理加速复杂分析任务,较传统硬盘方案快数十倍。

二、技术演进

服务器内存技术历经数十年发展,始终围绕“速度、容量、可靠性”三大核心需求迭代升级:

-

DDR内存的进化

双倍数据速率(DDR)内存自DDR1(2000年)至DDR5(2021年),带宽提升近10倍。DDR5单根内存条容量可达128GB,工作电压降至1.1V,能效比显著优化。例如,DDR5的“片上ECC”功能可自动修正单比特错误,提升系统稳定性。 -

3D堆叠与HBM技术

高带宽内存(HBM)通过3D堆叠技术将多个DRAM芯片垂直集成,配合超宽接口(如1024位),带宽可达TB/s级。英伟达A100 GPU搭载的HBM2e内存,带宽达600GB/s,为AI训练提供极致数据吞吐能力。 -

非易失性内存(NVM)的突破

英特尔Optane持久内存(PMEM)结合了内存的高速与硬盘的非易失性,可在断电后保留数据。其延迟(约350ns)介于DDR内存与SSD之间,适用于需要持久化存储的高频交易场景。 -

纠错与容错技术

服务器内存普遍采用ECC(错误检查与纠正)技术,可检测并修正单比特错误,检测多比特错误。部分高端系统支持“内存镜像”或“热插拔”功能,进一步降低宕机风险。

三、内存性能对服务器的影响

内存的容量、速度与可靠性直接决定服务器的整体表现,其影响贯穿硬件设计、软件优化与运维成本全链条。

-

延迟与吞吐量的博弈

内存延迟(如DDR5的CL40时钟周期)与带宽(如DDR5-6400的51.2GB/s)共同决定数据传输效率。在高频交易系统中,内存延迟每降低10ns,订单处理速度可提升2%-3%。 -

容量瓶颈与成本权衡

内存不足会导致“交换”(Swapping)现象,即系统将内存数据转储至硬盘,引发性能断崖式下跌。研究表明,内存容量每增加1倍,数据库查询响应时间可降低40%-60%。但内存成本占服务器总成本的20%-30%,需在性能与预算间寻找平衡点。 -

虚拟化与多租户挑战

在云计算环境中,内存超分配(Overcommitment)技术允许分配超过物理容量的内存,但需依赖内存气球驱动(Balloon Driver)或页面共享(Page Sharing)动态调整。若管理不当,可能导致“内存风暴”,引发虚拟机集体卡顿。 -

能效与绿色计算

内存功耗占服务器总功耗的10%-15%。DDR5的低电压特性(1.1V vs DDR4的1.2V)可降低单条内存功耗约8%。对于大型数据中心,内存能效优化每年可节省数百万度电。

四、内存优化策略

为充分发挥内存性能,需从硬件配置、系统调优与运维管理三方面综合施策:

- 硬件选型原则

- 容量规划:根据工作负载特性(如内存密集型、计算密集型)预留20%-30%冗余。例如,8核CPU建议配置64GB内存以支持并发任务。

- 速度匹配:确保内存频率与CPU支持的最高频率一致,避免因“内存瓶颈”限制CPU性能。

- 通道优化:启用多通道内存模式(如四通道DDR4),可提升带宽近4倍。

- 系统级调优

- NUMA架构优化:在多路CPU系统中,通过

numactl工具将内存分配至与CPU物理相邻的节点,减少跨节点访问延迟。 - 透明大页(THP):启用Linux的THP功能(默认2MB页),减少页表项数量,降低TLB(转换后备缓冲器)缺失率。

- 交换空间管理:将交换分区(Swap)配置在高速SSD上,并限制其使用比例(如不超过内存容量的10%)。

- NUMA架构优化:在多路CPU系统中,通过

- 应用层优化

- 缓存策略:利用Redis等内存数据库缓存热点数据,减少数据库查询次数。

- 内存池化:在容器化环境中,通过内存限制(

memory.limit_in_bytes)防止单个容器占用过多资源。 - 垃圾回收调优:在Java应用中,调整JVM堆内存大小(

-Xms/-Xmx)与垃圾回收器(如G1 GC),减少Full GC引发的停顿。

五、未来展望

随着AI、物联网与边缘计算的兴起,服务器内存正面临新一轮技术革命:

- CXL协议与内存解耦:Compute Express Link(CXL)协议允许CPU、GPU与加速器共享内存池,打破传统“内存墙”限制。

- 存算一体架构:通过将计算单元嵌入内存芯片(如UpMem的PIM架构),实现数据原地计算,能效比提升10倍以上。

- 量子内存探索:量子内存利用量子比特存储信息,理论上可实现指数级容量扩张,但尚处于实验室阶段。

结语

服务器内存虽不似CPU般引人注目,却是支撑系统高效运行的“隐形引擎”。从DDR5的带宽飞跃到CXL的内存池化,内存技术的每一次突破都在推动数据中心向更高密度、更低延迟的方向演进。未来,随着存算一体与量子内存的成熟,内存或将彻底重塑计算架构,成为数字世界的“新大脑”。对于企业而言,深入理解内存特性并实施精细化优化,不仅是提升性能的关键,更是在云计算时代保持竞争力的核心要素。

文章正下方可以看到我的联系方式:鼠标“点击” 下面的 “威迪斯特-就是video system 微信名片”字样,就会出现我的二维码,欢迎沟通探讨。