Linux服务器编程实践118 - 服务器的可扩展性设计:水平扩展与垂直扩展的方案

在Linux服务器编程领域,随着业务规模增长,"可扩展性"逐渐成为衡量服务器架构优劣的核心指标。当用户量从千级突破到百万级,从单节点服务到分布式集群,如何通过合理的扩展方案应对流量冲击,避免性能瓶颈?本文将围绕服务器可扩展性的两大核心方向——垂直扩展与水平扩展,结合Linux系统特性与编程实践,拆解设计思路、技术方案及落地细节,并通过代码示例与可视化图表,帮助开发者构建弹性、高可用的服务器架构。

一、可扩展性的核心目标与Linux服务器的挑战

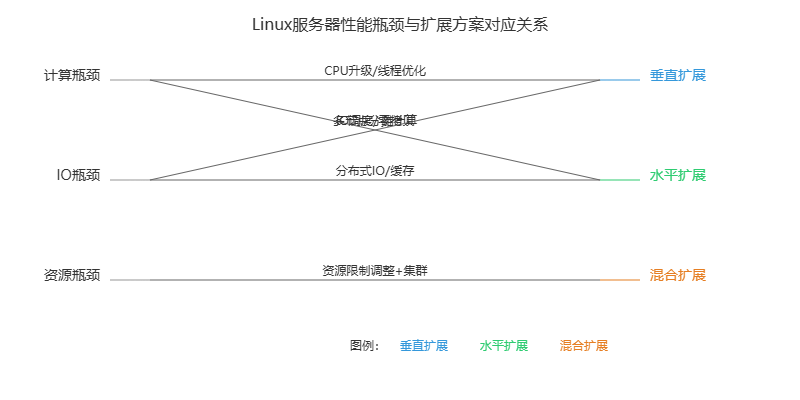

服务器可扩展性的本质,是在成本可控的前提下,通过调整资源投入或架构设计,实现服务能力的线性增长。对于Linux服务器而言,常见的性能瓶颈集中在三个维度:

- 计算瓶颈:单CPU核心处理并发请求能力有限,多线程/多进程调度开销增加

- IO瓶颈:网络IO(如TCP连接数、数据包吞吐量)或磁盘IO(如日志写入、数据库读写)饱和

- 资源瓶颈:内存不足(如连接缓存、会话存储)、文件描述符限制(Linux默认单进程最大FD数为1024)

针对这些瓶颈,垂直扩展与水平扩展提供了两种截然不同的解决思路:垂直扩展是"强化个体",通过升级单节点硬件或优化系统配置提升性能;水平扩展是"壮大群体",通过增加节点数量分摊负载。二者并非互斥关系,在实际架构中常结合使用(如先垂直优化单节点,再水平扩展集群)。

图1:Linux服务器性能瓶颈与扩展方案对应关系

二、垂直扩展:单节点性能最大化的实践方案

垂直扩展(Vertical Scaling)又称"向上扩展",核心是通过硬件升级与系统/代码优化,提升单个服务器节点的处理能力。其优势是无需修改架构设计,成本低、实施快;缺点是存在物理上限(如单CPU最大核心数、单服务器最大内存),无法应对超大规模流量。

2.1 硬件层面:针对性升级核心组件

根据服务器的业务类型(如CPU密集型、IO密集型),选择关键硬件进行升级:

| 业务类型 | 核心瓶颈 | 硬件升级方案 | Linux优化配合 |

|---|---|---|---|

| CPU密集型(如数据分析、加密解密) | CPU计算能力不足 | 升级多核CPU(如从4核→32核)、提升CPU主频 | 开启CPU超线程(echo 1 > /sys/devices/system/cpu/cpuX/online)、优化进程亲和性(taskset命令绑定进程到指定CPU核心) |

| IO密集型(如Web服务器、数据库) | 网络IO/磁盘IO延迟 | 升级万兆网卡、使用NVMe SSD(替换SATA硬盘) | 配置网卡多队列(RSS)、启用SSD TRIM(fstrim命令)、优化IO调度器(echo mq-deadline > /sys/block/sda/queue/scheduler) |

| 内存密集型(如缓存服务器、会话存储) | 内存不足导致Swap频繁 | 扩展内存至128GB/256GB | 关闭Swap(swapoff -a)、优化内核内存分配(调整/proc/sys/vm/swappiness为0)、使用大页内存(hugepage) |

2.2 系统层面:突破Linux内核限制

Linux默认配置为通用场景优化,针对高并发服务器需调整内核参数与资源限制,常见优化项如下:

2.2.1 突破文件描述符限制

Linux中,socket、文件、管道等均以文件描述符(FD)形式存在,默认单进程最大FD数为1024,远无法满足高并发场景(如万级TCP连接)。需通过以下步骤修改:

# 1. 临时修改(当前会话有效)

ulimit -n 65535 # 单个进程最大FD数

echo 655350 > /proc/sys/fs/file-max # 系统全局最大FD数

# 2. 永久修改(重启生效)

# 编辑/etc/security/limits.conf,添加:

* soft nofile 65535

* hard nofile 65535

# 编辑/etc/sysctl.conf,添加:

fs.file-max = 655350

net.core.somaxconn = 65535 # TCP连接队列最大长度

sysctl -p # 生效配置

2.2.2 优化TCP网络参数

针对高并发TCP服务器(如Web服务器、游戏服务器),需调整TCP连接建立、断开及数据传输相关参数,减少延迟与丢包:

# /etc/sysctl.conf 核心优化项

net.ipv4.tcp_tw_reuse = 1 # 允许复用TIME_WAIT状态的端口

net.ipv4.tcp_tw_recycle = 1 # 快速回收TIME_WAIT连接(需谨慎使用,NAT环境可能触发问题)

net.ipv4.tcp_fin_timeout = 30 # TIME_WAIT状态超时时间(默认60秒)

net.ipv4.tcp_syn_retries = 3 # SYN请求重试次数(默认5次,减少无效重试)

net.core.netdev_max_backlog = 10000 # 网卡接收队列最大长度

net.ipv4.tcp_max_syn_backlog = 10000 # TCP半连接队列最大长度(应对SYN Flood攻击)

2.3 代码层面:单节点性能压榨技巧

结合《Linux高性能服务器编程》中提到的"零拷贝"、"IO复用"等技术,优化代码逻辑,减少资源浪费:

2.3.1 使用IO复用替代多线程

传统多线程模型中,每个TCP连接对应一个线程,线程切换开销(上下文切换、栈内存占用)随连接数增加急剧上升。使用epoll(Linux特有)IO复用技术,单进程可管理数万连接,显著降低开销。

// 基于epoll的高并发TCP服务器核心代码示例

#include

#include

#include

#include

#include

#define MAX_EVENTS 10240 // 最大监听事件数

#define PORT 8080

int main() {

int listen_fd = socket(AF_INET, SOCK_STREAM, 0);

struct sockaddr_in addr;

addr.sin_family = AF_INET;

addr.sin_port = htons(PORT);

addr.sin_addr.s_addr = htonl(INADDR_ANY);

bind(listen_fd, (struct sockaddr*)&addr, sizeof(addr));

listen(listen_fd, 1024);

// 创建epoll实例

int epoll_fd = epoll_create1(0);

struct epoll_event ev, events[MAX_EVENTS];

ev.events = EPOLLIN;

ev.data.fd = listen_fd;

epoll_ctl(epoll_fd, EPOLL_CTL_ADD, listen_fd, &ev);

while (1) {

// 等待事件就绪(非阻塞,仅当有事件时返回)

int nfds = epoll_wait(epoll_fd, events, MAX_EVENTS, -1);

for (int i = 0; i < nfds; i++) {

if (events[i].data.fd == listen_fd) {

// 新连接到来

int conn_fd = accept(listen_fd, NULL, NULL);

ev.events = EPOLLIN | EPOLLET; // 边缘触发(高效模式)

ev.data.fd = conn_fd;

epoll_ctl(epoll_fd, EPOLL_CTL_ADD, conn_fd, &ev);

} else if (events[i].events & EPOLLIN) {

// 已有连接可读数据

char buf[1024];

ssize_t len = read(events[i].data.fd, buf, sizeof(buf));

if (len <= 0) {

// 连接关闭或出错,移除epoll监听

epoll_ctl(epoll_fd, EPOLL_CTL_DEL, events[i].data.fd, NULL);

close(events[i].data.fd);

continue;

}

// 处理数据(如回声服务)

write(events[i].data.fd, buf, len);

}

}

}

close(listen_fd);

close(epoll_fd);

return 0;

}

2.3.2 零拷贝技术减少数据拷贝开销

传统文件传输(如Web服务器发送静态文件)需经过"磁盘→内核缓存→用户缓存→内核socket缓存→网卡"四次数据拷贝,使用sendfile零拷贝函数可减少至"磁盘→内核缓存→网卡"两次拷贝,显著提升IO效率。

// 使用sendfile实现零拷贝文件传输(Web服务器静态文件发送)

#include

#include

#include

#include

// 向客户端发送指定文件

void send_file(int client_fd, const char* file_path) {

int file_fd = open(file_path, O_RDONLY);

if (file_fd < 0) {

const char* err_msg = "HTTP/1.1 404 Not Found

File Not Found";

write(client_fd, err_msg, strlen(err_msg));

return;

}

// 获取文件大小

struct stat stat_buf;

fstat(file_fd, &stat_buf);

// 发送HTTP响应头

char header[512];

snprintf(header, sizeof(header),

"HTTP/1.1 200 OK

Content-Length: %ld

Content-Type: text/html

",

stat_buf.st_size);

write(client_fd, header, strlen(header));

// 零拷贝发送文件内容

sendfile(client_fd, file_fd, NULL, stat_buf.st_size);

close(file_fd);

}

图2:传统IO与零拷贝IO数据流向对比

三、水平扩展:分布式集群的弹性架构设计

水平扩展(Horizontal Scaling)又称"向外扩展",核心是通过增加服务器节点数量,将负载分摊到多个节点上。其优势是理论上无性能上限,可通过动态增减节点应对流量波动;缺点是需解决分布式架构的核心挑战(如负载均衡、数据一致性、节点通信)。

3.1 水平扩展的核心架构组件

一个完整的Linux服务器水平扩展架构,通常包含以下组件,各组件协同工作实现"负载分摊-数据同步-故障转移":

- 负载均衡层:将客户端请求均匀分发到后端节点(如Nginx、LVS、HAProxy)

- 应用服务层:多个相同的应用节点(如Web服务器、API服务器),无状态设计(不存储会话数据)

- 数据存储层:分布式数据库(如MySQL主从、MongoDB集群)或缓存(如Redis集群),保证数据一致性

- 服务发现层:动态感知节点上下线(如etcd、Consul),更新负载均衡规则

图3:Linux服务器水平扩展架构示意图

3.2 关键技术实践:从请求分发到数据同步

3.2.1 负载均衡:Nginx反向代理配置

Nginx是Linux下常用的HTTP/TCP负载均衡工具,支持轮询、加权轮询、IP哈希等多种调度算法,可轻松实现后端节点的负载分摊。以下是Web服务器集群的Nginx配置示例:

# /etc/nginx/nginx.conf 核心配置

http {

upstream web_servers {

# 后端应用节点(IP:端口),weight表示权重(值越大,分配到的请求越多)

server 192.168.1.101:8080 weight=5;

server 192.168.1.102:8080 weight=3;

server 192.168.1.103:8080 weight=2;

# 健康检查:当节点不可用时,自动剔除(需安装nginx-upstream-check-module)

check interval=3000 rise=2 fall=3 timeout=1000 type=tcp;

}

server {

listen 80; # 监听客户端请求端口

server_name www.example.com; # 域名

location / {

# 反向代理到后端集群

proxy_pass http://web_servers;

# 传递客户端真实IP(后端节点可通过X-Real-IP获取)

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header Host $host;

}

}

}

配置说明:通过upstream定义后端节点集群,weight调整节点权重(适合不同性能的节点),健康检查功能确保请求不发送到故障节点。

3.2.2 无状态应用设计:会话共享

水平扩展的前提是应用节点无状态(不存储会话数据,如用户登录状态),否则请求分发到不同节点会导致会话丢失。解决方案是将会话数据存储到分布式缓存(如Redis),所有节点共享会话:

// 基于Redis的会话共享示例(C语言,使用hiredis客户端库)

#include

#include

#include

// 连接Redis服务器

redisContext* redis_connect(const char* host, int port) {

redisContext* ctx = redisConnect(host, port);

if (ctx == NULL || ctx->err) {

if (ctx) printf("Redis connect error: %s

", ctx->errstr);

else printf("Redis connect error: NULL

");

return NULL;

}

// 若Redis有密码,需认证

// redisCommand(ctx, "AUTH your_password");

return ctx;

}

// 存储会话数据(key:会话ID,field:用户ID,value:用户信息)

int save_session(redisContext* ctx, const char* session_id, const char* user_id, const char* user_info) {

redisReply* reply = redisCommand(ctx, "HMSET %s user_id %s info %s", session_id, user_id, user_info);

if (reply == NULL || strcmp(reply->str, "OK") != 0) {

freeReplyObject(reply);

return -1;

}

// 设置会话过期时间(30分钟)

redisCommand(ctx, "EXPIRE %s 1800", session_id);

freeReplyObject(reply);

return 0;

}

// 获取会话数据

char* get_session(redisContext* ctx, const char* session_id, const char* field) {

redisReply* reply = redisCommand(ctx, "HGET %s %s", session_id, field);

if (reply == NULL || reply->type != REDIS_REPLY_STRING) {

freeReplyObject(reply);

return NULL;

}

char* result = strdup(reply->str);

freeReplyObject(reply);

return result;

}

应用节点处理流程:客户端登录成功后,生成唯一会话ID(如UUID),将会话ID与用户信息存储到Redis,同时将会话ID通过Cookie返回给客户端;后续请求中,客户端携带会话ID,应用节点从Redis查询会话数据,实现跨节点会话共享。

3.2.3 数据一致性:MySQL主从复制

水平扩展中,数据存储层需保证多节点数据一致。以MySQL为例,采用"主从复制"架构:主库负责写操作(INSERT/UPDATE/DELETE),从库负责读操作(SELECT),主库将写操作日志(binlog)同步到从库,从库重放日志实现数据同步。

# MySQL主库(192.168.1.100)配置 /etc/my.cnf

[mysqld]

server-id = 1 # 唯一ID(主库≠从库)

log_bin = /var/log/mysql/mysql-bin.log # 开启binlog日志

binlog_format = row # 行级复制(数据一致性更高)

binlog_do_db = test_db # 仅同步test_db数据库

# MySQL从库(192.168.1.101)配置 /etc/my.cnf

[mysqld]

server-id = 2

relay_log = /var/log/mysql/relay-bin.log # 中继日志(存储主库binlog)

read_only = 1 # 从库设为只读(仅超级用户可写)

# 从库执行SQL,开启主从复制

CHANGE MASTER TO

MASTER_HOST='192.168.1.100',

MASTER_USER='repl_user', # 主库创建的复制用户

MASTER_PASSWORD='repl_password',

MASTER_LOG_FILE='mysql-bin.000001', # 主库当前binlog文件名

MASTER_LOG_POS=154; # 主库当前binlog位置

START SLAVE; # 启动从库复制进程

应用层配合:通过代码或中间件(如Sharding-JDBC)实现"写主库、读从库",分摊数据库负载。例如,用户注册(写操作)请求发送到主库,用户资料查询(读操作)请求发送到从库。

四、扩展方案的选择与演进路径

垂直扩展与水平扩展并非对立关系,在服务器架构演进中,通常遵循"先垂直优化,后水平扩展"的路径,具体选择需结合业务阶段、成本预算与技术复杂度:

4.1 不同业务阶段的扩展策略

| 业务阶段 | 并发规模 | 推荐扩展方案 | 核心目标 |

|---|---|---|---|

| 初创期 | 日活1000以下,并发连接<100 | 垂直扩展为主(优化Linux配置、代码逻辑) | 快速上线,控制成本 |

| 成长期 | 日活1万-10万,并发连接100-1000 | 垂直扩展+基础水平扩展(Nginx+2-3个应用节点) | 提升稳定性,应对流量增长 |

| 成熟期 | 日活10万以上,并发连接>1000 | 完整水平扩展架构(负载均衡+多应用节点+分布式存储) | 弹性伸缩,高可用(99.99%可用性) |

4.2 关键注意事项

- 无状态优先:水平扩展的前提是应用无状态,设计初期需避免节点本地存储会话、缓存等数据

- 监控先行:通过Linux工具(如top、netstat、vmstat)或监控系统(如Prometheus+Grafana)定位瓶颈,避免盲目扩展

- 故障预案:水平扩展需考虑节点故障应对(如负载均衡健康检查、数据库主从切换),避免单点故障

- 成本平衡:垂直扩展硬件升级成本随配置提升呈指数增长(如32核CPU价格远高于4核×8),当单节点成本过高时,优先选择水平扩展

总结:Linux服务器的可扩展性设计,本质是在"单节点性能"与"多节点协作"之间找到平衡。垂直扩展是"内功修炼",通过硬件升级与系统优化挖掘单节点潜力;水平扩展是"团队协作",通过分布式架构实现服务能力的无限扩展。在实际项目中,需结合业务需求与技术现状,选择合适的扩展方案,并持续迭代优化,才能构建出弹性、高可用的服务器系统。