rustdesk自建服务器实现跨平台远程运维语音系统

RustDesk 自建服务器实现跨平台远程运维语音系统

在企业IT运维日益复杂、远程办公常态化的大背景下,传统的远程控制工具正面临前所未有的挑战:数据隐私难以保障、连接延迟高、交互方式单一。尤其在关键故障响应场景中,仅靠视觉反馈的“看和点”操作模式已显疲态——当系统告警弹出时,如果能有一声清晰的语音提示:“数据库服务已停止”,那将极大提升处置效率。

正是在这种需求驱动下,RustDesk 作为一款开源、可自建、端到端加密的远程桌面解决方案,迅速成为技术团队的新宠。而与此同时,语音合成技术也迎来了质变。B站开源的 IndexTTS 2.0 模型,凭借其零样本音色克隆与情感解耦能力,让“用你熟悉的声音播报系统状态”成为可能。

本文不打算堆砌术语或罗列功能清单,而是带你一步步构建一个真正可用的“会说话”的远程运维系统——它不仅能连上远端机器,还能在关键时刻开口提醒你,甚至模仿你的声音告诉你:“磁盘空间只剩5%了”。

当远程控制开始“发声”

想象这样一个场景:你在外地出差,突然收到短信通知公司服务器CPU持续100%。打开手机上的RustDesk客户端,连接进机房主机,画面卡顿不说,还得手动翻日志才能定位问题。但如果系统能在检测到异常后,自动通过你的手机扬声器播放一句:“应用服务A因内存泄漏导致CPU飙升,请立即检查JVM堆栈。”——这种听觉层面的主动反馈,是不是瞬间提升了掌控感?

这就是我们想做的:把 RustDesk 的远程控制能力 和 IndexTTS 2.0 的智能语音生成能力 结合起来,打造一个具备“语音感知”的运维助手。

它的核心逻辑其实很简单:

- 运维事件发生 → 提取文本信息(如“硬盘即将写满”)

- 发送给语音合成服务 → 生成带情感、有音色的音频

- 在控制端实时播放 → 实现无屏干预下的快速响应

但这背后涉及的技术链路却相当完整:从私有化部署的安全架构,到低延迟音视频传输,再到高质量语音生成与播放调度。

为什么是 IndexTTS 2.0?

市面上的TTS模型不少,但大多数要么需要长时间训练定制音色,要么无法精细控制语速和情绪。而 IndexTTS 2.0 的出现,解决了几个长期困扰工程落地的痛点。

零样本音色克隆:5秒录音就能“复制”一个人的声音

传统语音克隆通常需要30分钟以上的纯净录音,并进行微调训练。而 IndexTTS 2.0 只需一段5秒的参考音频,即可提取出稳定的声纹嵌入向量(speaker embedding),实现即插即用的音色复现。

更关键的是,这个过程完全脱离训练环节,推理阶段直接注入,非常适合动态切换不同角色语音的应用场景。比如你可以为“系统告警”设置低沉严肃的男声,为“日常提醒”使用轻快女声,所有切换都在毫秒级完成。

音色与情感真正解耦:自由组合“谁在说”和“怎么说”

很多TTS模型一旦用了某段参考音频,就会连带着把原音频的情绪也复制过来。你想用张三的声音平静地说一句话,结果听起来像是他在咆哮——这是因为音色和情感被耦合在一起了。

IndexTTS 2.0 通过梯度反转层(GRL)在训练阶段强制分离这两个维度。最终实现了真正的“解耦”:你可以指定使用“用户A的音色” + “愤怒的情感向量”,或者输入自然语言指令如“温柔地读出来”,由内置的 T2E 模块自动解析成对应的情感参数。

这在运维场景中意义重大。例如,普通通知可以用温和语气播报,而严重故障则切换为急促、高亢的警告语调,形成听觉上的分级预警体系。

精确时长控制:首次在自回归模型中实现音画同步

以往自回归TTS模型输出长度不可控,很难做到“在PPT翻页瞬间完成解说”。但 IndexTTS 2.0 引入了可控时长模式,支持通过 duration_ratio 参数调节整体语速(0.75x ~ 1.25x),并结合长度调节器(Length Regulator)精确压缩或扩展音素持续时间。

实测显示,在影视配音任务中,其音画同步误差可控制在±50ms以内,足以满足教学演示、自动化巡检等对节奏敏感的场景。

多语言与中文优化:不只是“能说中文”,而是“说得准”

相比通用TTS模型常犯的多音字错误(如“重”读作“zhòng”而非“chóng”),IndexTTS 2.0 支持拼音混合输入,允许开发者显式标注发音。这对于专业术语、缩写词的准确朗读至关重要。

例如,你可以这样输入:

欢迎使用远程运维系统,当前负载为 chong fu zai (重负荷)

确保系统不会误读为“重复载”。

构建语音服务模块

我们可以将 IndexTTS 2.0 封装为一个独立的 REST API 服务,供 RustDesk 客户端或其他监控系统调用。

from fastapi import FastAPI, File, UploadFile

from pydantic import BaseModel

import torch

from indextts import IndexTTSModel

import soundfile as sf

import uuid

import os

app = FastAPI(title="IndexTTS 2.0 Voice Service")

# 加载模型(建议GPU环境)

device = "cuda" if torch.cuda.is_available() else "cpu"

model = IndexTTSModel.from_pretrained("bilibili/IndexTTS-2.0").to(device)

model.eval()

class TTSRequest(BaseModel):

text: str

duration_ratio: float = 1.0

emotion_type: str = "text" # text | vector | audio

emotion_value: str = "平静"

reference_audio_path: str = None

output_format: str = "wav"

@app.post("/tts")

async def generate_speech(req: TTSRequest):

# 生成唯一文件名

output_file = f"outputs/{uuid.uuid4().hex}.wav"

# 构造配置

config = {

"duration_ratio": req.duration_ratio,

"control_mode": "controlled",

"tone_embedding_source": req.reference_audio_path,

"emotion_control": {

"type": req.emotion_type,

"value": req.emotion_value

},

"input_with_pinyin": False

}

# 生成梅尔频谱

with torch.no_grad():

mel = model.generate(req.text, config)

wav = model.vocoder.inference(mel.unsqueeze(0)).squeeze().cpu().numpy()

# 保存音频

sf.write(output_file, wav, samplerate=24000)

return {"audio_url": f"/static/{os.path.basename(output_file)}"}

启动命令:

uvicorn tts_api:app --host 0.0.0.0 --port 8000

这样,任何系统只需发送一个JSON请求,就能获得定制化语音文件。配合缓存机制(如Redis记录已合成内容),还能避免重复计算,显著降低GPU负载。

RustDesk 私有化部署:安全底座的搭建

再好的语音系统,如果建立在不安全的通信链路上,也只是空中楼阁。RustDesk 的最大优势就在于——一切皆可自建。

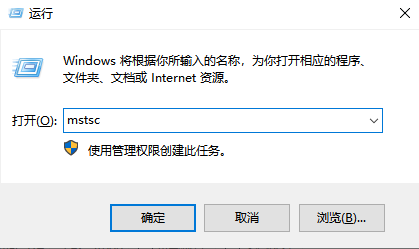

核心组件部署(Ubuntu 示例)

# 下载服务端二进制包

wget https://github.com/rustdesk/rustdesk-server/releases/latest/download/rustdesk-server-linux-x64.tar.gz

tar -xf rustdesk-server-linux-x64.tar.gz

cd rustdesk-server

# 启动 ID/信令服务器(hbbs)

./hbbs -i 0.0.0.0 -p 21115 -k your_public_key &

# 启动中继服务器(hbb_r)

./hbb_r -i 0.0.0.0 -p 21116 &

默认情况下,RustDesk 客户端会尝试连接公共服务器。我们需要通过配置文件强制其使用私有服务:

{

"api_url": "https://your-api-domain.com",

"key": "-----BEGIN RSA PRIVATE KEY-----

...",

"server": "your-server-ip:21115",

"relay": "your-server-ip:21116",

"enable_audio": true,

"enable_file_transfer": true,

"disable_cloud": true

}

其中 "disable_cloud": true 是关键,它禁用了所有公共节点发现机制,确保流量100%走内网链路。

安全加固建议

- 使用 Let’s Encrypt 证书启用 HTTPS/TLS;

- 通过 Nginx 反向代理暴露服务,隐藏真实IP;

- 配置防火墙规则,仅开放 21115(TCP)、21116(TCP/UDP) 端口;

- 定期轮换密钥对,防止长期暴露风险;

- 数据库存储建议迁移到 MySQL,便于审计与备份。

融合工作流:让系统“主动说话”

现在我们将两个系统打通,实现事件驱动的语音播报。

典型流程如下:

sequenceDiagram

participant Monitor as 监控系统

participant RustDesk as RustDesk Client

participant TTS as IndexTTS Server

participant User as 运维人员

Monitor->>TTS: POST /tts {text: "CPU过载", emotion: "紧急"}

TTS-->>Monitor: 返回 audio_url

Monitor->>RustDesk: 触发播放指令

RustDesk->>User: 播放语音告警

User->>RustDesk: 响应处理(重启服务等)

具体实现可以是在被控主机上运行一个轻量级Agent,监听系统指标:

# 示例:shell脚本检测磁盘使用率

df -h | grep '/$' | awk '{if ($5+0 > 90) print $5}' &&

curl -X POST http://tts-server:8000/tts

-H "Content-Type: application/json"

-d '{

"text": "警告:根分区使用率超过90%",

"emotion_value": "急促且严肃"

}'

返回的音频URL可通过 RustDesk 的剪贴板共享机制传递给控制端,再由本地播放器自动触发。

实际应用场景不止于“报警”

很多人以为语音集成就是做个告警播报,但实际上它的潜力远不止于此。

无障碍访问:视障工程师也能高效运维

对于视力受限的技术人员,传统的图形界面远程控制几乎无法使用。但如果我们把屏幕元素转化为语音描述,并配合键盘快捷键导航,就能构建一套完整的语音辅助系统。

例如:

- 登录成功 → 播报“Ubuntu 22.04 桌面环境已加载”

- 鼠标悬停文件夹 → 朗读“当前聚焦:logs,包含3个子目录”

- 执行命令后 → 回读前五行输出结果

这种“语音GUI”模式,能让更多人平等地参与技术工作。

教学演示:精准匹配PPT翻页节奏

在远程培训中,讲师常常需要一边共享屏幕一边讲解。若提前录制好每页PPT的解说词,并利用 IndexTTS 的时长控制功能严格对齐翻页时间,就可以实现全自动播放。

比如设置 duration_ratio=0.9 让语速稍快,确保在翻页前两秒结束,留出过渡空白。整个过程无需人工干预,适合批量制作标准化课程。

多角色身份识别:一听就知道“谁在说话”

在一个团队共用运维账号的场景中,如何区分操作来源?除了日志记录外,我们还可以为每位成员预设专属语音模板。

当“张工”执行重启命令时,系统播报:“张工正在重启Web服务”——使用的是他本人音色克隆的声音。这种“自我播报”机制既增强了责任感,又提升了协作透明度。

设计之外的思考:不只是技术整合

这套系统的价值,不在于用了多少前沿模型,而在于它重新定义了人机交互的边界。

我们习惯于“发现问题 → 查看日志 → 分析原因 → 执行修复”的被动响应模式,但当系统具备了“表达能力”之后,它可以变成一个主动的协作者。它不再沉默地等待被查看,而是会主动说:“我知道哪里出了问题。”

当然,也有一些现实考量需要注意:

- 资源分配:IndexTTS 推理对GPU有一定要求,低并发场景可用ONNX Runtime做CPU加速;

- 延迟控制:语音生成应在500ms内完成,否则会影响用户体验;

- 权限隔离:语音服务应与核心控制系统解耦,防止单点故障;

- 隐私保护:参考音频存储需加密,且明确告知用户用途。

写在最后

从最初的VNC到如今的RustDesk + IndexTTS组合,远程控制的本质正在发生变化。它不再只是一个“远程显示器”,而是一个可以倾听、理解、甚至表达的智能终端。

也许不久的将来,当我们深夜接到服务器宕机通知时,不再需要慌忙打开电脑,而是听到手机里传来熟悉的声音:“别担心,我已经自动重启了服务,这是日志摘要……”

这才是我们追求的技术温度——不是冷冰冰的代码,而是懂你、帮你、陪你解决问题的伙伴。