零成本搭建本地大语言模型:无需服务器,支持离线访问

文章介绍了在本地部署大语言模型的完整流程。首先安装开源工具Ollama,支持多系统,然后下载大模型(如llama3)。接着安装图形化UI工具MaxKB,配置与Ollama的连接,最后通过浏览器访问使用。整个过程无需服务器,完全免费,支持离线对话。

大家好,今天来介绍一下如何部署一个属于你自己的、本地、可离线访问的大语言模型。可以通过浏览器随时随地和他进行交互,不需要购买任何服务器。在你自己的笔记本电脑上就可以完成整个部署的过程使用到的所有软件都是开源免费的,不需要缴纳任何费用。支持国内外主流的大模型,可以使用语音对话,也可以嵌入到你自己的网站上,做一个智能客服或者AI助手。怎么样?想不想来试试看呢?下面就来看一下具体的操作步骤。

安装和配置Ollama

首先我们需要先来安装一个大模型的部署和管理工具Ollama,它可以帮助我们在本地更加方便快速地部署和使用各种大模型。

Ollama的安装非常简单,打开它的官方网站之后,点击下面的下载按钮,可以看到它同时支持mac、linux和windows三大主流操作系统,根据自己的系统选择对应的版本安装就可以了。

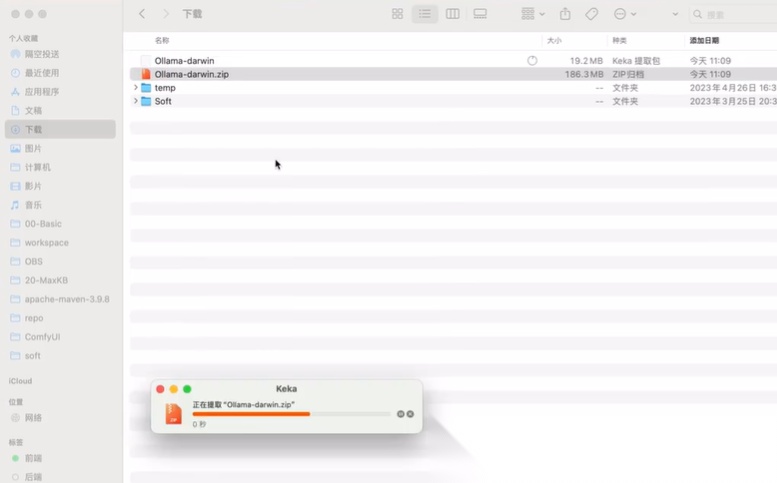

Mac用户会下载一个压缩文件,解压之后会得到一个名字叫做alama的应用程序,直接把它拖到应用程序里面就可以了。

Linux系统的话,直接复制下面这一行命令,然后在终端里面粘贴进去,执行一下就可以自动下载和安装。Ollama这种方式对网络环境的要求比较高,如果下载不了的话,也可以下载一个离线的安装包,然后使用下面的解压缩命令来安装,也是OK的。

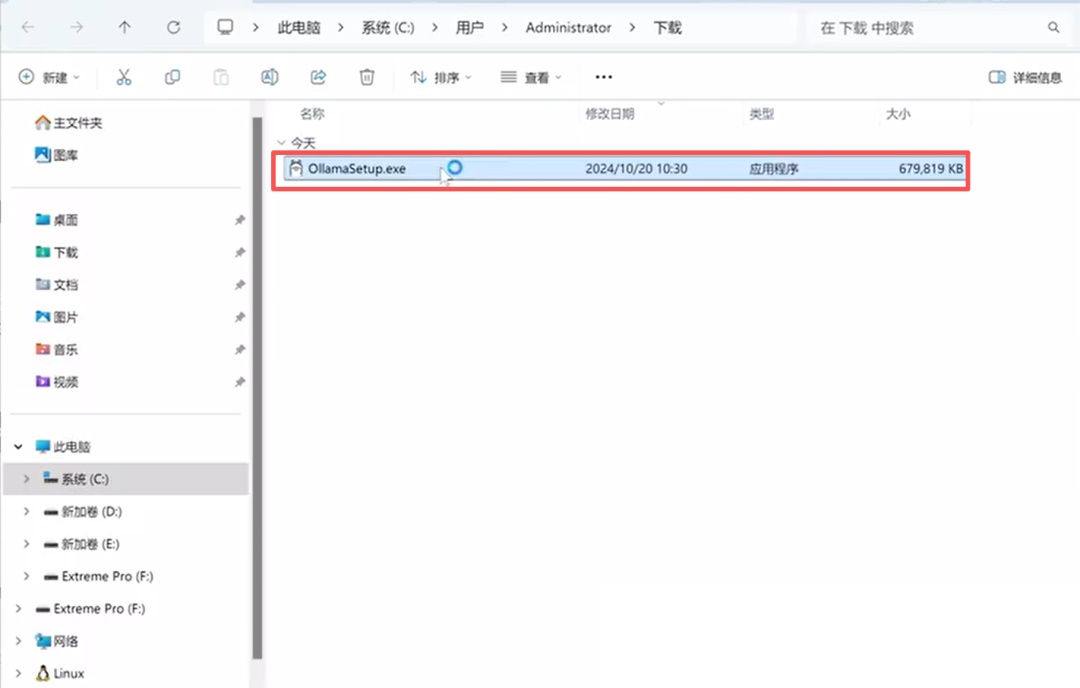

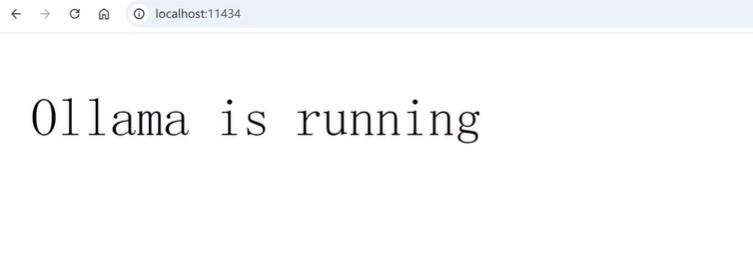

Windows系统的话,会下载一个安装文件,双击打开这个文件之后,点击install安装就可以了。 安装完成之后,在右下角会有一个羊驼的小图标,表示Ollama已经启动。然后我们打开一个浏览器,在地址栏输入localhost:11434之后回车,如果能够看到Ollama is running这样的字样,就表示Ollama已经成功安装,并且在本地运行起来了。

安装完成之后,在右下角会有一个羊驼的小图标,表示Ollama已经启动。然后我们打开一个浏览器,在地址栏输入localhost:11434之后回车,如果能够看到Ollama is running这样的字样,就表示Ollama已经成功安装,并且在本地运行起来了。

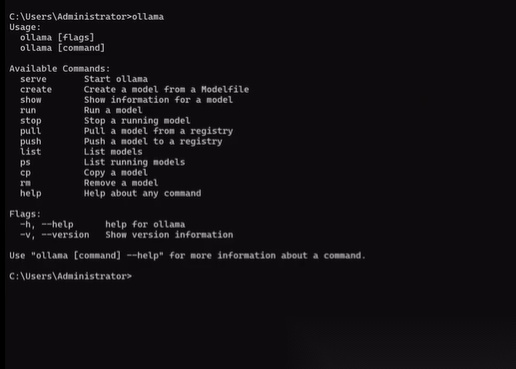

接下来我们打开一个命令行终端,看一下Ollama如何来使用。Windows系统的话,可以直接在搜索框里面输入CMD或者power shell,回车之后就会打开一个命令行终端,然后在里面输入Ollama之后,回车就会看到Ollama命令的各种参数和用法。

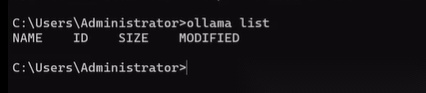

比如可以输入一个Ollama list,就可以查看本地安装的所有大模型。因为现在我们还没有安装任何模型,所以这里是空的。

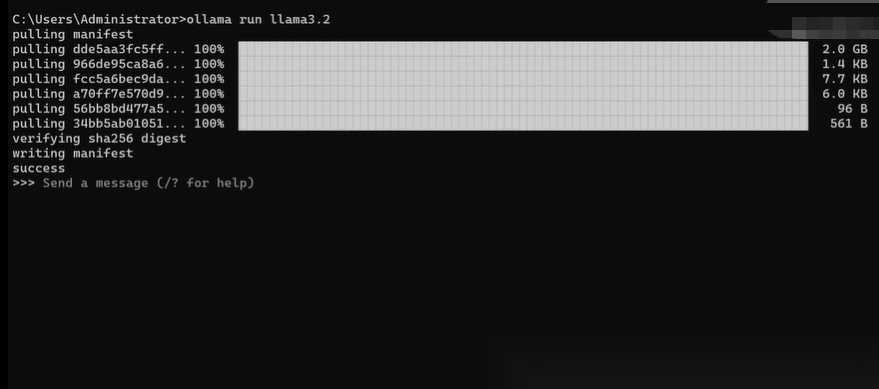

我们需要下载一个大模型文件,这里就以llama3为例来演示。注意,这里大家不要搞混了,Ollama是一个用来部署大模型的工具,而llama是由Meta推出的一个大语言模型,目前最新的版本是3.2,我们输入ollama run llama 3.2之后,回车就会自动下载和安装模型文件。下载完成之后,我们就可以在本地使用这个模型了。这里我们可以直接在命令行和他对话。输入“/bye”就可以退出对话。

安装和配置UI界面

接下来我们再来安装一个图形化的UI界面,这样就可以通过浏览器来和本地模型进行交互了我们需要借助一个开源的工具MaxKB。MaxKB是一个基于大语言模型和rag的开源知识库问答系统。大语言模型大家都非常熟悉了,而Rag很多同学可能还不是很了解,稍微来简单介绍一下。Rag的全称是检索增强生成,是一种将检索与生成相结合的自然语言处理技术。由于大语言模型都是基于预训练的数据集训练出来的,如果你的问题超出了这个数据集的范围,那么它生成的内容很可能是不够准确的,甚至会一本正经的胡说八道,这也就是我们常说的大模型的幻觉。为了解决这个问题,人们提出了将检索模型和生成模型结合在一起的方法,通过从外部数据源添加一些上下文和背景知识,确保大模型有足够的信息来生成更加准确和可靠的答案,这就是Rag的基本原理。Rag模式下的工作流程是这样的,首先用户提出一个问题之后,这个问题会被作为一个查询条件,从你的向量化知识库中进行检索,找到最相关的信息或者文档。然后这些信息和文档会随着问题一起输入到大模型中。最后大模型会根据这些信息来生成答案,确保生成的答案更加准确和可靠。

MaxKB就是这样一个基于大模型和Rag的系统,它的官方网址是http://maxkb.cn,打开之后,点击页面中间的下载安装按钮,就会来到它的官方文档页面。这里有非常详细的安装和使用说明。

官方文档上提示我们只支持在Ubuntu和CentOS这样的linux系统上使用。但是实际上在windows和mac系统上也是可以使用的。我们可以通过根据文档的步骤一步步去操作。

【这边给出文档的链接:离线安装 - MaxKB 文档】

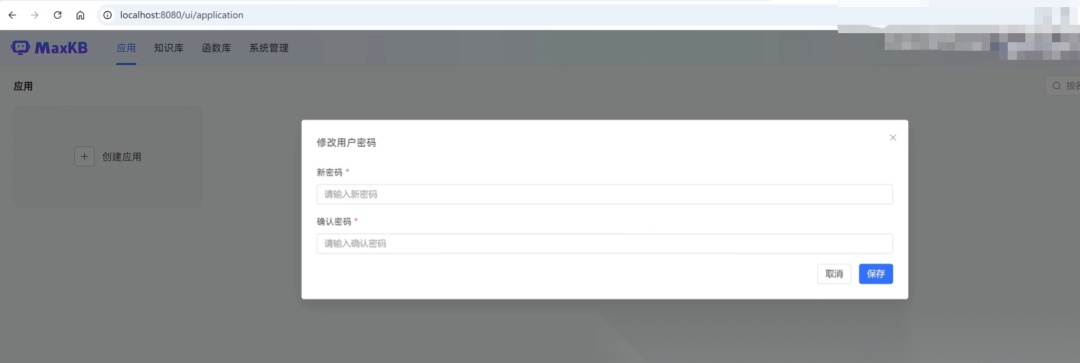

完成之后,就可以通过浏览器来访MaxKB的web界面了。打开浏览器之后,输入localhost:8080。然后输入默认的用户名和密码,用户名是admin,密码是:MaxKB@123…。第一次登陆的话,我会要求我们修改默认的密码,那么就来修改一下。

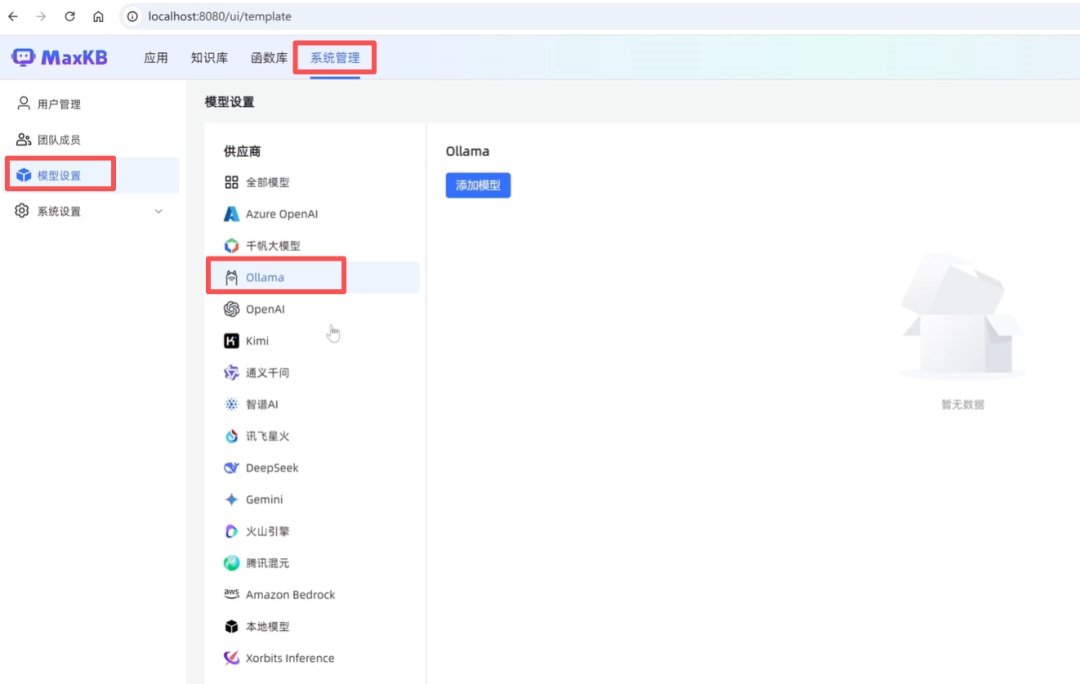

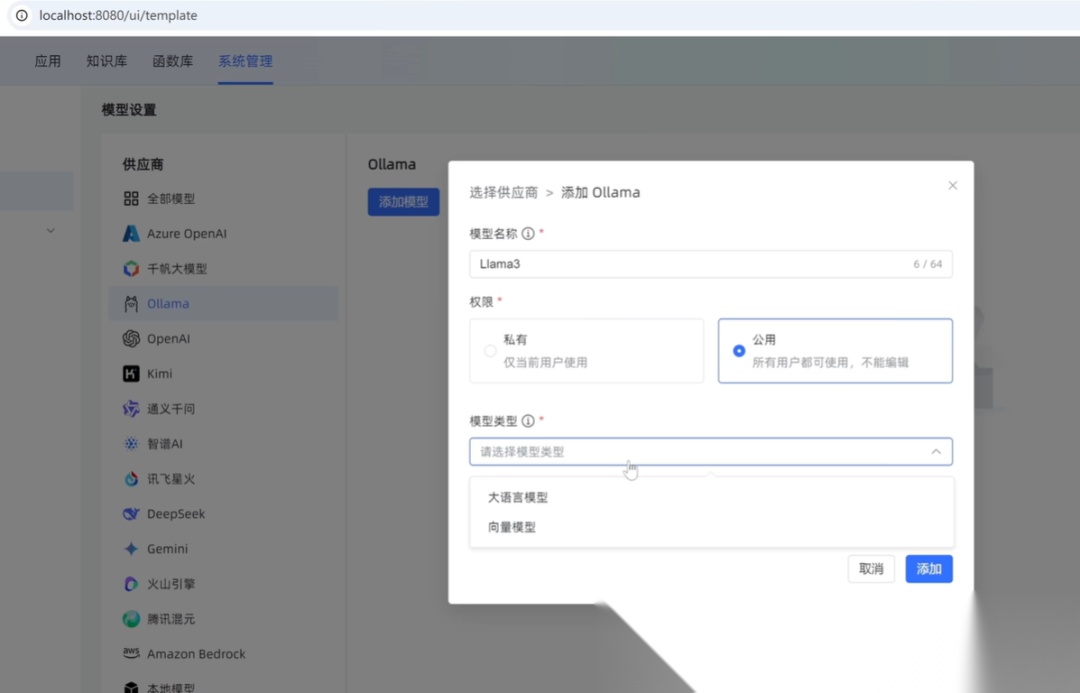

登录之后,在系统管理这里有个模型设置选项,在这里就可以配置我们想要使用的各种大模型。可以看到支持的模型有很多种,基本上目前市场上主流的大模型都是支持的。这里我们选择一个ollama之后,然后点击右侧添加模型按钮来添加一个新的模型文件名称。这里可以随便填一个,比如就叫做Llama3。权限这里可以根据自己的需求选择私有或者公开模型类型,可以选择大语言模型或者向量模型。

这里我们选择大语言模型,基础模型选择一个llama3,API域名这里需要填写一个可以访问到Ollama的地址,配置不正确的话会提示API域名无效。APIK的话可以随便填写一个,然后点击添加按钮之后,模型就添加好了。

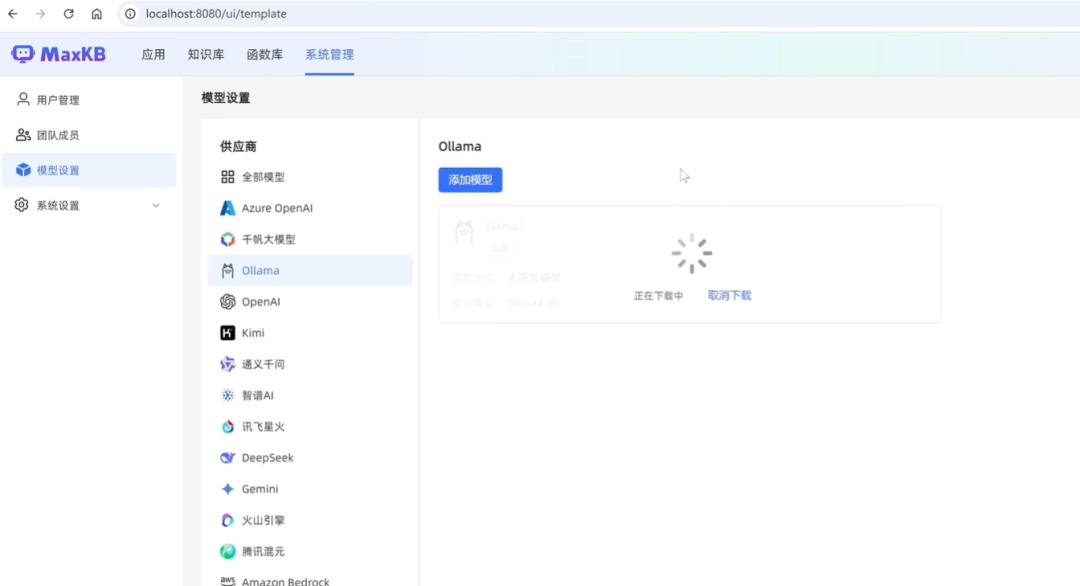

这里由于我们刚刚选择的模型是llama 3,而我们在命令行里面下载的是llama 3.2模型列表里面还没有这个llama3的模型,所以会为我们自动下载。除了Ollama之外,还可以添加其他的模型,方法也都是类似的。

添加完模型之后,我们还需要再添加一个应用来使用这个模型。

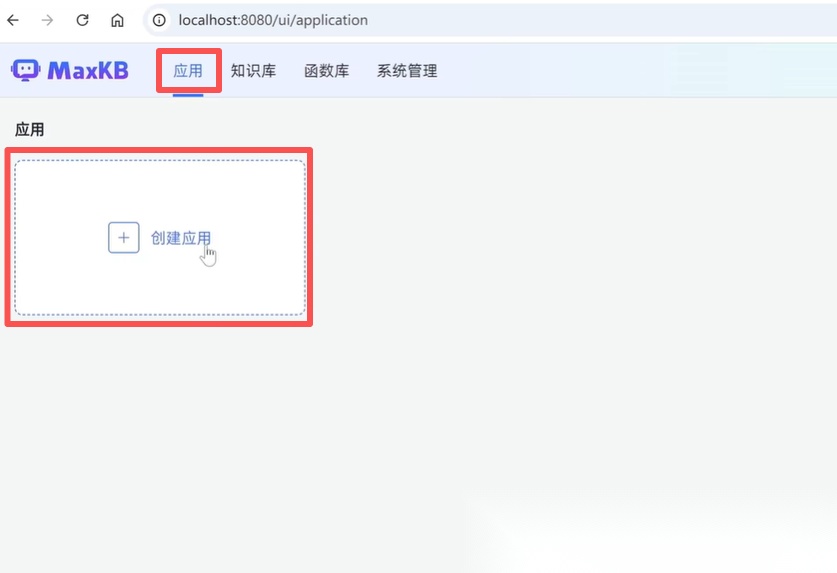

点击左侧的应用之后,再点击创建应用按钮,应用名称可以随便添一个,描述这里并不是必选的,可以不添。下面应用类型,这里选择简单配置就可以。

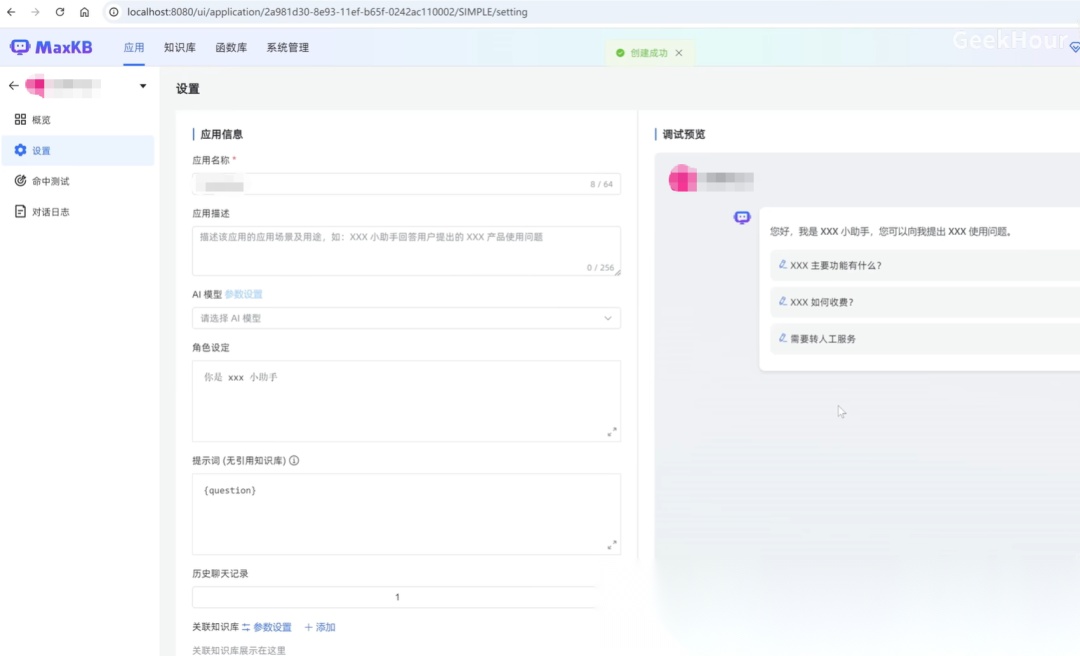

然后点击创建就会跳转到应用的配置页面,这里需要再配置一下使用的AI模型,选择我们刚刚配置好的llama3模型下面的角色设定以及开场白等内容,可以换成你对应的产品或者ID。然后就可以在右侧的测试输入框里面输入一些问题,比如来输入一个hello,稍等一下就可以看到他的回答了。

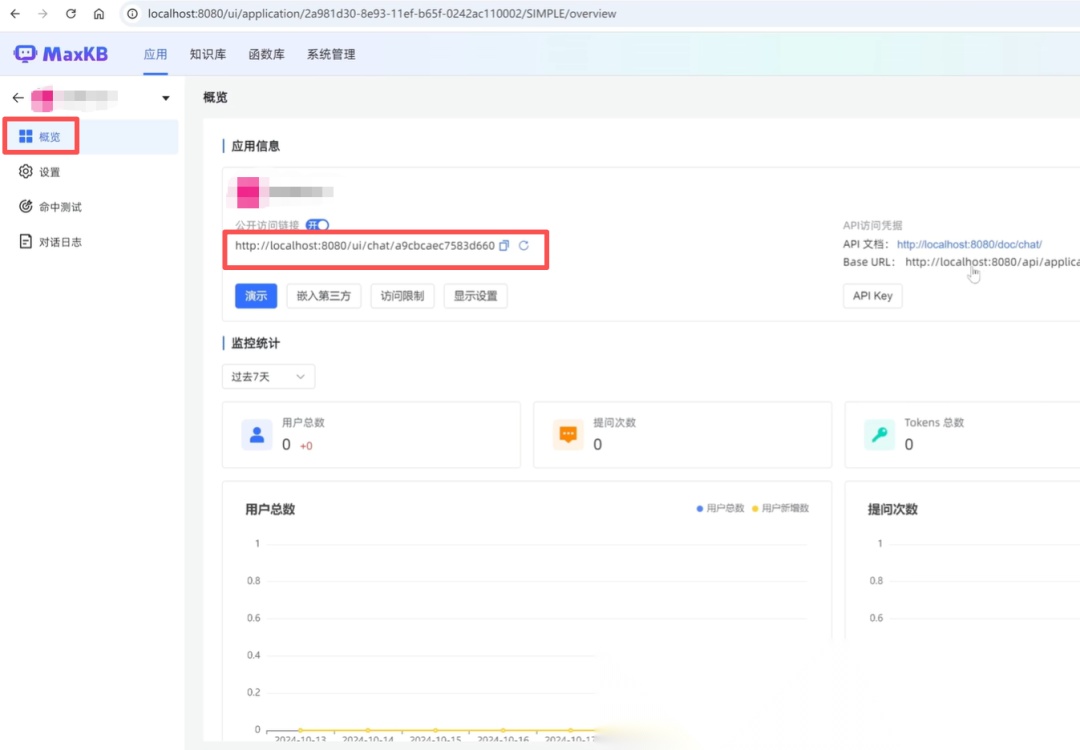

设置好之后,点击右上角的保存并发布按钮,这样一个应用就配置好了。在概览页面可以看到它的一些基本信息,包括它的公开访问链接,API接口地址以及一些监控和统计信息等等。

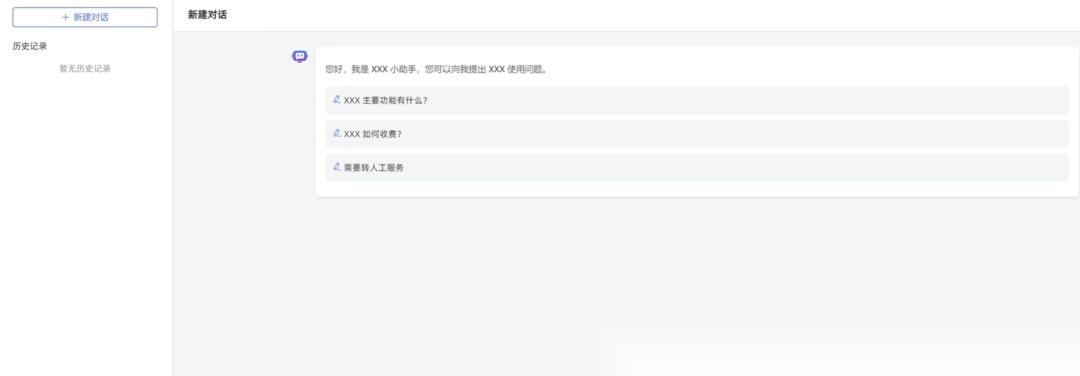

复制一下这个公开访问链接之后,在浏览器中新建一个标签页,然后把这个地址粘贴进去,执行一下就可以看到我们刚刚配置的应用已经在浏览器中运行起来了。这样我们就可以通过浏览器来和我们的大模型进行交互了。

结语

好了,这样我们就完成了大模型的本地部署并创建了UI界面,小编虽然使用的windows系统来进行演示的,但实际上在mac和linux系统上也是完全可行的,只需要稍微调整一下个别步骤的命令或者操作就可以了。当然,有任何问题欢迎在评论区留言。

关注小编|带你了解更多

如何学习AI大模型 ?

“最先掌握AI的人,将会晚掌握AI的人有竞争优势,晚掌握AI的人比完全不会AI的人竞争优势更大”。 在这个技术日新月异的时代,不会新技能或者说落后就要挨打。

老蓝我作为一名在一线互联网企业(保密不方便透露)工作十余年,指导过不少同行后辈。帮助很多人得到了学习和成长。

我是非常希望可以把知识和技术分享给大家,但苦于传播途径有限,很多互联网行业的朋友无法获得正确的籽料得到学习的提升,所以也是整理了一份AI大模型籽料包括:AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、落地项目实战等 免费分享出来。

👉点击即可获取大模型学习包2024年最新版👈

- AI大模型学习路线图

- 100套AI大模型商业化落地方案

- 100集大模型视频教程

- 200本大模型PDF书籍

- LLM面试题合集

- AI产品经理资源合集

大模型学习路线

想要学习一门新技术,你最先应该开始看的就是学习路线图,而下方这张超详细的学习路线图,按照这个路线进行学习,学完成为一名大模型算法工程师,拿个20k、15薪那是轻轻松松!

视频教程

首先是建议零基础的小伙伴通过视频教程来学习,其中这里给大家分享一份与上面成长路线&学习计划相对应的视频教程。文末有整合包的领取方式

技术书籍籽料

当然,当你入门之后,仅仅是视频教程已经不能满足你的需求了,这里也分享一份我学习期间整理的大模型入门书籍籽料。文末有整合包的领取方式

大模型实际应用报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。文末有整合包的领取方式

大模型落地应用案例PPT

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。文末有整合包的领取方式

大模型面试题&答案

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。文末有整合包的领取方式

领取方式

这份完整版的 AI大模型学习籽料我已经上传CSDN,需要的同学可以微⭐扫描下方CSDN官方认证二维码免费领取!

。