老板:导入不就是读文件存库?我:这7行代码能把服务器炸了

📉 理想中的 Excel:整齐划一的方阵

在老板眼里,Excel 导入就是把表格里的数据“复制粘贴”到数据库里:

|

动作 |

代码行数 (理想状态) |

描述 |

|

读取文件 |

2 行 | File file = receive(); |

|

解析表格 |

3 行 | List |

|

存入数据库 |

2 行 | db.saveAll(users); |

总计:7 行。

甚至有现成的库(如 Apache POI),感觉分分钟搞定。

现实是: 只要你敢用这 7 行代码上线,第一天服务器就会崩溃,第二天你会收到 50 个 Bug 单。

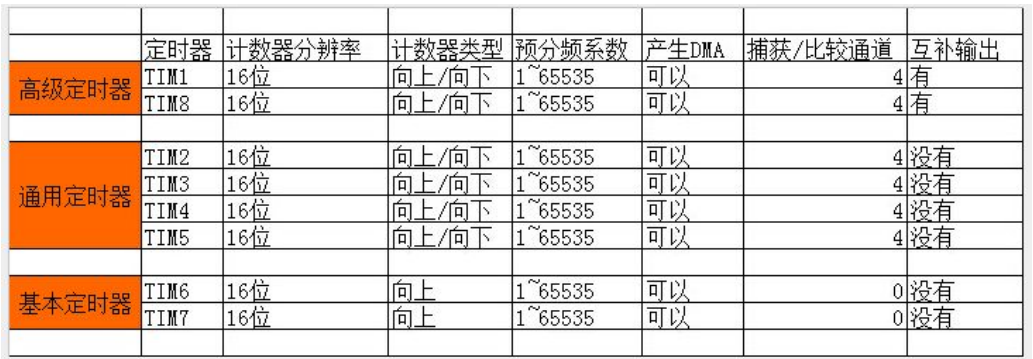

💥 第一关:内存核弹 (Out Of Memory)

这是所有新手的必经之路。

你用 Apache POI 的默认模式(DOM 模式)去读取 Excel。这个模式会把整个 Excel 文件解压,把所有单元格的对象一次性加载到内存里。

场景: 运营为了省事,把全年的订单数据(50 万行,文件大小 100MB)一次性上传了。

结果: 在服务器内存里,这 100MB 的文件会膨胀成 2GB - 5GB 的对象树。

结局: Java 虚拟机(JVM)内存瞬间被吃光,抛出 java.lang.OutOfMemoryError,服务器宕机,全公司系统不可用。运维提刀赶来。

防御代码(流式处理):

-

• SAX 模式 / EasyExcel: 不能一次性读完。必须用流式读取(SAX),读一行,处理一行,丢弃一行(垃圾回收)。就像吃面条,不能把一碗面全塞嘴里,要一根一根吸。

代码增加:+100 行。你需要重写整个解析逻辑,使用监听器(Listener)模式,而不是简单的

List = read()。

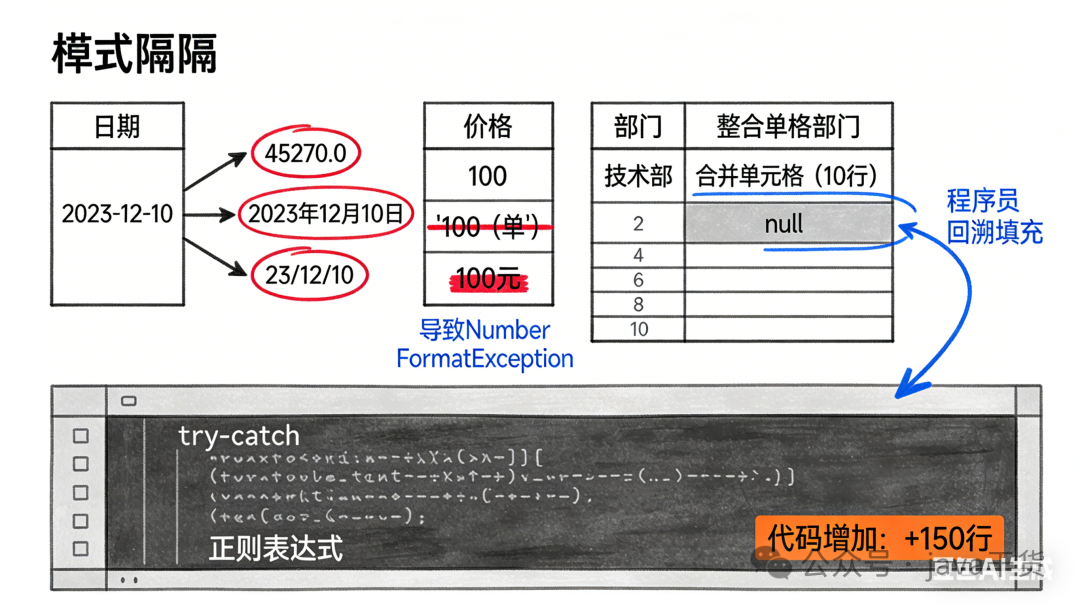

📅 第二关:格式的千层套路

解决了内存问题,你以为就能读到数据了?太天真了。人类制作的 Excel 是世界上最脏的数据源。

-

1. 日期陷阱:

-

• 你在 Excel 里看到的

2023-12-10。 -

• 程序读出来的可能是:

45270.0(Excel 内部的时间戳浮点数)。 -

• 或者读出来是文本

"2023年12月10日",甚至是"23/12/10"。 -

• 你需要写一个万能的日期解析器来猜它到底是什么格式。

-

-

2. 看起来是数字:

-

• 价格列写着

100。 -

• 程序读出来报错:

NumberFormatException。 -

• 原因:运营不小心按了个空格,变成了

"100 ";或者为了对齐,前面加了单引号'100;或者有人填了"100元"。

-

-

3. 合并单元格(恶魔的发明):

-

• 左边一列“部门”合并了 10 行。

-

• 程序读第一行:有部门数据。

-

• 程序读第二行到第十行:部门是空的(null)!

-

• 你必须写代码去“回溯”上一行的值来填充这些空洞。

-

代码增加:+150 行。全是各种

try-catch、正则替换、格式判断、空值填充。

⏳ 第三关:时间的黑洞 (HTTP 超时)

好了,内存撑住了,格式也解析了。现在要往数据库插这 50 万条数据。

如果一条一条插,可能要跑 30 分钟。

但是,浏览器和 Nginx 的HTTP 请求超时时间通常只有 60 秒。

用户点击“上传” -> 转圈圈 60 秒 -> “504 Gateway Time-out”。

用户以为失败了,又点了一次“上传”。

结果: 后台其实还在跑,现在跑了两个任务,数据库里插了双份数据。

防御代码(异步化):

-

1. 上传即返回: 收到文件后,先存到磁盘,立刻告诉前端:“文件已接收,正在处理中,任务ID是 10086。”

-

2. 后台静默处理: 启动一个独立线程慢慢跑导入。

-

3. 前端轮询: 前端每隔 2 秒问一次:“任务 10086 跑完没?进度多少了?”

-

4. 进度条: 你得在代码里实时计算:

当前处理行数 / 总行数,存到 Redis 里供前端查询。

代码增加:+200 行。从一个简单的接口变成了“上传接口 + 查询状态接口 + 异步任务调度”。

📝 第四关:史上最难的“错误反馈”

如果导入成功还好。如果失败了呢?

用户传了 1000 行,第 502 行的手机号填错了。

你直接报错“导入失败”?用户会疯的:“哪一行错了?你告诉我啊!”

你必须做一个**“错误报告下载”**功能:

-

1. 程序不能一遇到错就停,要跳过错误行继续跑。

-

2. 把所有错误行记录下来,生成一个新的 Excel 文件。

-

3. 在最后一列用红字标出:“手机号格式错误”、“身份证号重复”。

-

4. 让用户下载这个“只有错误数据”的表格,改完再重新上传。

代码增加:+150 行。相当于你不仅要写“导入”,还要顺便写个“带格式样式的导出”。

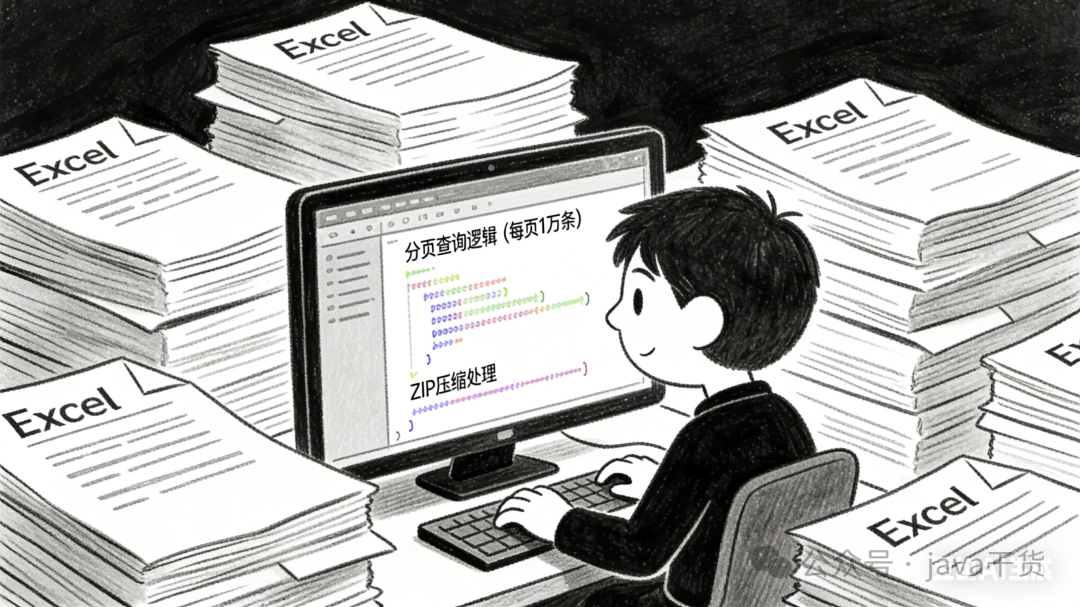

📤 导出:另一个方向的崩溃

聊完导入,简单说一句导出(下载 Excel)。

导出就是导入的逆向崩溃:

-

1. 海量数据导出: 老板要导出“过去 5 年的所有订单”。数据库查出来 500 万行。

-

2. 全表扫描: 你的 SQL 把数据库内存撑爆了。

-

3. 分页查询: 必须每页查 10000 条,写到 Excel,清空内存,再查下一页。

-

4. ZIP 压缩: Excel 单个 Sheet 最多 104 万行。超过了怎么办?自动分 Sheet,或者分多个 Excel 文件打包成 Zip 下载。

💡 结论:Excel 是程序员的磨刀石

为什么一个 Excel 导入功能要写几千行代码,甚至要搞异步架构?

因为你是在做ETL(Extract, Transform, Load)工具。

你是在把非结构化、脏乱差、不可控的人类数据,清洗成结构化、严谨、精密的数据库数据。

这个过程中的每一步,都是在为人类的随意买单。

所以,下次当你在页面上看到一个**“批量导入”**按钮时,请对它保持敬畏。那个小小的按钮后面,可能跑着一个复杂的异步状态机和几十个正则表达式。