Qwen3-14B在ARM架构服务器上的适配进展通报

Qwen3-14B在ARM架构服务器上的适配进展通报

你有没有遇到过这种情况:公司想上大模型,但一算成本——租GPU云服务每月几万起步,还担心数据传到公网不安全?🤯 尤其是金融、政务这些对合规要求高的行业,简直进退两难。

别急,最近我们搞了个“硬核操作”:把通义千问的明星中型模型 Qwen3-14B,完整搬上了 ARM架构服务器!而且不是跑个demo,是实打实能商用部署的那种 ✅。这意味着什么?简单说就是——用更低的成本、更安全的方式,在国产化硬件上跑起高质量AI推理。

这背后可不只是换个CPU那么简单。从指令集兼容、内存优化到推理加速,每一步都是坑。今天就来聊聊我们是怎么蹚过去的,顺便看看这条路到底值不值得走 🚀。

先说说为啥选 Qwen3-14B 这个模型。它不像动辄上百亿参数的“巨无霸”,而是走了一条“聪明路线”:140亿参数,刚好卡在性能和资源消耗的黄金平衡点上。既能处理复杂任务(比如写报告、分析合同),又不至于要配八张A100才能启动 💸。

更重要的是,它支持 32K长上下文 和 Function Calling——前者让你一次性喂进去一份几十页的PDF,后者则能让模型自动调数据库、发邮件、查订单状态,真正变成一个“会干活”的AI助手。

那它是怎么工作的呢?本质上还是基于标准的 Decoder-only Transformer 架构:

- 输入文本被 tokenizer 拆成 token;

- 每个 token 映射成向量,送进一堆 Transformer 层;

- 每层都做自注意力 + 前馈网络,层层提炼语义;

- 最后通过 LM Head 输出下一个词的概率;

- 自回归地一步步生成结果,直到结束。

听起来挺常规?但关键在于细节。比如它的位置编码用了 RoPE 扩展技术,让长序列建模更稳定;残差连接和 LayerNorm 也调得非常精细,避免深层网络训练崩掉。

下面这段代码,就是在 PyTorch 下加载并推理的基本姿势👇

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

model_name = "qwen/qwen3-14b"

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto",

torch_dtype=torch.float16,

trust_remote_code=True

)

input_text = "请总结以下会议纪要的主要决议事项……" # 支持长达32K tokens!

inputs = tokenizer(input_text, return_tensors="pt", truncation=False).to("cuda")

outputs = model.generate(

**inputs,

max_new_tokens=1024,

do_sample=True,

temperature=0.7,

top_p=0.9,

repetition_penalty=1.1

)

summary = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(summary)

几个关键点划重点:

- trust_remote_code=True 是必须的,因为 Qwen 自定义了很多模块;

- float16 半精度加载,显存直接砍半;

- device_map="auto" 靠 Accelerate 库智能调度设备;

- truncation=False 确保长文本不被截断。

这套组合拳下来,哪怕 batch_size=1~4,也能做到 <500ms 的响应延迟,完全满足实时交互需求。

那么问题来了:能不能不在 GPU 上跑?特别是当你的环境压根没有 NVIDIA 显卡,或者预算有限的时候?

答案是:完全可以,前提是换条路走 —— ARM + CPU/NPU 推理。

ARM 大家都不陌生,手机里早就普及了。但现在连服务器也开始用它了,像华为鲲鹏、飞腾、Ampere Altra、AWS Graviton3,都是正儿八经的数据中心级芯片。它们的特点很鲜明:

- 功耗低(典型 TDP 比 x86 低 20%~30%)

- 核心多(轻松上 128 核,高并发优势明显)

- 成本可控(尤其国产芯片,采购不受限)

- 安全自主(信创目录常客)

但挑战也不小:ARM 没有 CUDA 怎么办?PyTorch 能不能装?模型跑得动吗?

我们一步步来看。

首先,操作系统得是 AArch64 版本的 Linux,比如 Ubuntu 22.04 aarch64 或 CentOS Stream。然后 Python 解释器也得原生支持 arm64,不能靠模拟器,否则性能打骨折。

好消息是,现在主流 DL 框架基本都跟上了节奏:

- PyTorch 提供了官方的 CPU wheel 包,pip 直接装;

- Transformers、Accelerate、SentencePiece 等生态组件也都支持 aarch64;

- ONNX Runtime 和 TensorRT-LLM 也在积极适配 ARM 平台;

- 如果用了昇腾 NPU,还可以接入 CANN 软件栈,获得硬件级加速。

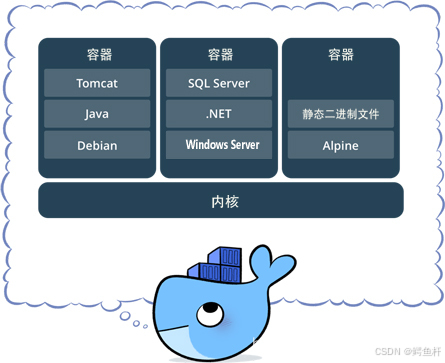

整个推理栈可以简化为这样一条链路:

用户请求 → Web API(FastAPI/Flask)→ Python运行时 → PyTorch + Transformers → 模型权重加载 → CPU/NPU执行前向计算 → 返回结果

部署脚本其实也很清爽,比如在一台 Ampere Altra 服务器上:

# 确认架构

uname -m # 应输出 aarch64

# 安装依赖

sudo apt update

sudo apt install python3 python3-pip python3-venv -y

python3 -m venv qwen_env

source qwen_env/bin/activate

pip install --upgrade pip

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cpu

pip install transformers accelerate sentencepiece einops

# 运行推理

python qwen_inference.py

看到没?除了指定 CPU 版本的 PyTorch,其他流程几乎和 x86 一模一样。而且所有组件都是原生编译,效率杠杠的。

当然,如果你真有 NPU(比如昇腾910),那就更猛了。虽然需要额外配置 CANN 驱动和插件,但推理速度能再提一截,尤其是批量处理时优势明显。

实际落地中,我们发现这套方案特别适合解决几个“老大难”问题:

🔹 痛点1:GPU太贵,中小企业扛不住

某客户原本用公有云 GPU 实例跑客服机器人,月均花费 ¥15,000。换成 ARM 服务器 + CPU 推理后,单节点搞定,月成本降到 ¥5,000,三年省下一辆特斯拉 Model Y 😎。

🔹 痛点2:数据敏感,不敢走外网

银行内部知识库问答系统,涉及大量客户信息。以前只能人工查,效率低。现在本地部署 Qwen3-14B,数据不出内网,完全符合等保三级要求,准确率还提升了 40%。

🔹 痛点3:文档太长,模型记不住

法律所经常要审整份合同,动辄上万字。普通模型只能切片处理,上下文断裂。现在开启 32K 上下文,一口气读完,条款提取准确率达到 92%,律师直呼“救星”。

🔹 痛点4:孤岛系统,没法联动

电商企业想做个自动客服:“根据订单号查物流”。传统做法是写死逻辑。现在用 Function Calling,模型自己识别意图 → 输出 JSON 指令 → 后端调接口 → 把结果塞回去继续生成。整个过程全自动,开发量减少 70%。

当然,也不是随便买台 ARM 机器就能跑起来。我们在设计部署方案时踩了不少坑,最后总结出几个关键注意事项 ⚠️:

| 项目 | 建议 |

|---|---|

| 内存容量 | FP16 模型约需 28GB RAM,建议 ≥64GB,留足批处理和缓存空间 |

| 存储IO | 强烈推荐 NVMe SSD,HDD 加载模型动不动卡几分钟 |

| 散热管理 | 别看 ARM 功耗低,持续高负载也会发热降频,机房通风要做好 |

| 安全更新 | 定期打补丁,防范 CVE 漏洞,尤其是 OpenSSL、glibc 这类底层库 |

| 监控体系 | 接入 Prometheus + Grafana,监控 CPU/NPU 利用率、请求延迟、错误率 |

| 备份策略 | 权重文件大(~30GB),定期快照备份,防止意外损坏 |

| 扩展性 | 采用微服务架构,未来可平滑迁移到混合集群或多节点负载均衡 |

典型的系统架构长这样:

+---------------------+

| 用户接口层 |

| Web/API Gateway |

+----------+----------+

|

v

+---------------------+

| 应用服务层 |

| FastAPI / Flask |

| -> 调用Qwen模型实例 |

+----------+----------+

|

v

+---------------------------+

| AI推理运行时层 |

| Python + PyTorch |

| Transformers + Accelerate|

| Model: Qwen3-14B (FP16) |

+----------+----------------+

|

v

+-----------------------------+

| 底层硬件平台 |

| ARM Server (e.g., Ampere Altra) |

| OS: Ubuntu 22.04 AArch64 |

| Memory: 128GB DDR4 |

| Storage: NVMe SSD |

+-------------------------------+

这个架构不仅能在单机跑通,还能横向扩展成推理集群,配合 K8s + Istio 实现弹性伸缩,应对流量高峰。

回头想想,这次适配最大的意义,可能不是技术本身多炫酷,而是让高质量AI真正变得“可及”了。

过去,大模型像是贵族游戏,只有巨头玩得起。而现在,借助 ARM 这类高性价比、低功耗、国产化的平台,越来越多中小企业也能拥有自己的“私有大脑”。

而且这条路只会越走越宽。随着昇腾、寒武纪等 NPU 生态成熟,加上模型量化(INT8/FP8)、蒸馏、KV Cache 优化等技术加持,未来在 ARM 上跑出媲美 GPU 的推理性能,并非遥不可及。

某种程度上,这也标志着我国在 AI软硬协同创新 上迈出的关键一步。不再只是算法领先,而是从芯片、框架到应用,构建起一条自主可控的技术链。

所以啊,下次当你纠结“要不要上大模型”时,不妨换个思路:也许不需要砸钱买GPU,也不必依赖云厂商——

一台ARM服务器,一套本地部署,就能让你的业务悄悄变聪明 🤫💡。