顶会论文引用了 13 篇虚构的参考文献,连审稿人都在用 AI 摸鱼?

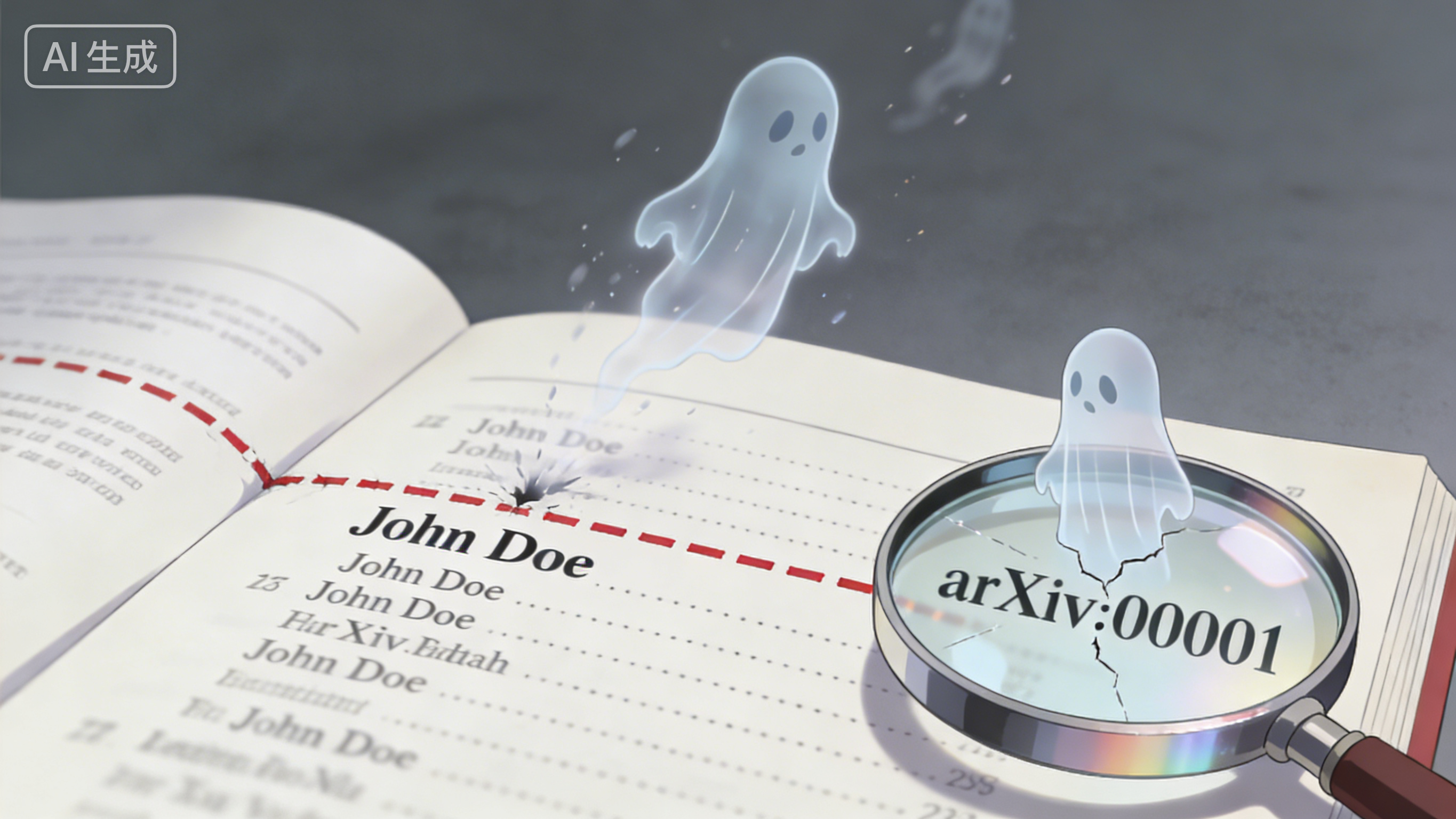

一篇被 NeurIPS 2025 接收的论文中,赫然出现这样的参考文献:

「John Doe and Jane Smith. Webvoyager: Building an end-to-end web agent…」

——这相当于中文论文里正经八百地引用《张三、李四 著〈量子力学导论〉》。

这不是段子,而是 GPTZero 检测报告 中真实记录的「幻觉引用」案例。更荒诞的是,同一篇论文还编造了 arXiv:2401.00001 这种明显是占位符的编号,仿佛作者在赶 deadline 时随手敲了串「00001」糊弄过去,却忘了替换。

幻觉引用的「光谱」:从 typo 到彻底虚构

GPTZero 将问题分为两类:

- 有缺陷的引用(flawed citation):作者名拼写错误、期刊卷期偏差、页码小错——这类问题人类也会犯,属于「可原谅的疏忽」。

- 幻觉引用(hallucinated citation):完全虚构的作者、不存在的期刊、伪造的 DOI 链接——例如

doi:10.1109/TNNLS.2021.3071234指向一个根本不存在的 IEEE 页面。

在检测到的 100 处问题中,最极端的案例是一篇论文虚构了 13 个完全不存在的参考文献,包括作者「Samuel LeCun Jackson」——把深度学习之父 Yann LeCun 和演员 Samuel L. Jackson 的名字缝合在一起,堪称 AI 的黑色幽默。

审稿人自己可能也在「摸鱼」

更值得玩味的是 Hacker News 讨论 中曝光的审稿乱象:有研究者收到 WACV 会议的审稿意见,同一段文字在「摘要」「优点」「缺点」四个栏目重复出现,且内容自相矛盾(既说「创新性突出」又说「毫无新意」)。这强烈暗示:审稿链条本身可能已被 AI 渗透——连抓作弊的人自己都在用作弊工具。

这背后是残酷的现实:2020–2025 年间,NeurIPS 投稿量暴增 220%(从 9,467 篇到 21,575 篇),而审稿人数量并未同比例增长。许多会议甚至让硕士生评审顶会论文,人均需在数天内审阅 20+ 篇。当人类审稿人自身都疲于奔命,指望他们逐条核对 30+ 条参考文献的 DOI 有效性,无异于痴人说梦。

为什么 BibTeX 会「幻觉」?

一个常见误解是:「作者只是让 AI 帮忙格式化参考文献,没想造假」。但技术上这说不通。

真实的 BibTeX 条目通常来自三类来源:

- 期刊官网导出的

.bib文件(权威但繁琐) - Google Scholar 的「引用」按钮(便捷但偶有错误)

- Zotero / Mendeley 等文献管理工具(需手动校验)

这些工具生成的条目极少出现完全虚构的作者。而 AI 幻觉引用的特征极为鲜明:

- 作者名是通用占位符(John Doe / Jane Smith)

- arXiv ID 为

XXXX或00001等占位符 - 期刊卷期页码组合违反出版规范(如 IEEE Transactions 2021 年根本不存在 32 卷 5600 页)

这更像是作者直接对 LLM 说:「帮我写一段关于多模态代理的背景,加 5 篇参考文献」,而非「请将这篇论文的作者列表转为 BibTeX 格式」。

自动化验证:技术上并不难

讽刺的是,检测幻觉引用是 LLM 最擅长的任务之一——因为参考文献是半结构化数据,存在明确的验证锚点(DOI、ISBN、arXiv ID)。已有工具如 Crossref API 可实时验证文献元数据,而 Semantic Scholar 甚至能追踪论文被后续研究引用时的上下文。

问题不在于技术,而在于学术出版流程仍未将引用视为「可验证对象」,而是当作「叙事性文本」。正如一位 Duke 大学研究者在 Hacker News 所言:

「我们仍把引用当作故事的一部分,而非需机器验证的依赖项。这种基于信任的模型在投稿量低时可行,但如今已不堪重负。」

理想的工作流应是:作者提交 .bib 文件 → 系统自动调用 DOI 验证服务 → 标记存疑条目 → 审稿人重点核查。这比要求人类逐条点击链接高效得多,且成本极低(一次 DOI 查询约 0.001 美元)。

幻觉引用为何值得警惕?

有人辩称:「背景章节的引用错误不影响论文核心结论」。但科学建立在可追溯的信任链上。若连最易验证的参考文献都造假,读者如何相信实验数据、代码实现等更难核查的部分?

更隐蔽的风险是污染学术基础设施:Google Scholar、Scopus 等索引系统会爬取论文中的参考文献。当虚构条目被收录,后续研究者可能「二次引用」这些幽灵文献,形成错误传播链。已有案例显示,某些 arXiv 论文因引用了不存在的「权威著作」,导致该虚构概念在后续研究中被反复讨论。

结语:工具无罪,懒惰有价

LLM 作为翻译工具(尤其对非英语母语研究者)或语法检查器,价值已被广泛认可。问题在于将内容生成外包给统计模型,却不履行人类作者的验证责任。

正如一位 Hacker News 用户的犀利吐槽:

「计算器也会出错(浮点误差、Excel 日期格式 bug),但我们仍用它——因为我们理解其局限并交叉验证结果。而许多人把 LLM 当作真理发生器,这本质是认知懒惰。」

学术出版系统确需改革:降低「发表或灭亡」压力、奖励可重复性研究、建立自动化验证流水线。但在系统变革前,每个署名作者都应记住:你名字印在论文上,意味着你对每一条参考文献的真实性负全责——哪怕它是由 AI「帮忙」生成的。

毕竟,科学史上最著名的造假案例(如「疫苗导致自闭症」论文)往往始于微小的诚信裂痕,最终酿成系统性信任崩塌。当 AI 让造假成本趋近于零时,坚守验证底线反而成了最昂贵的奢侈品——也是科学最后的护城河。