LangChain 实战第1天:环境验证+核心认知(理论基础打底)

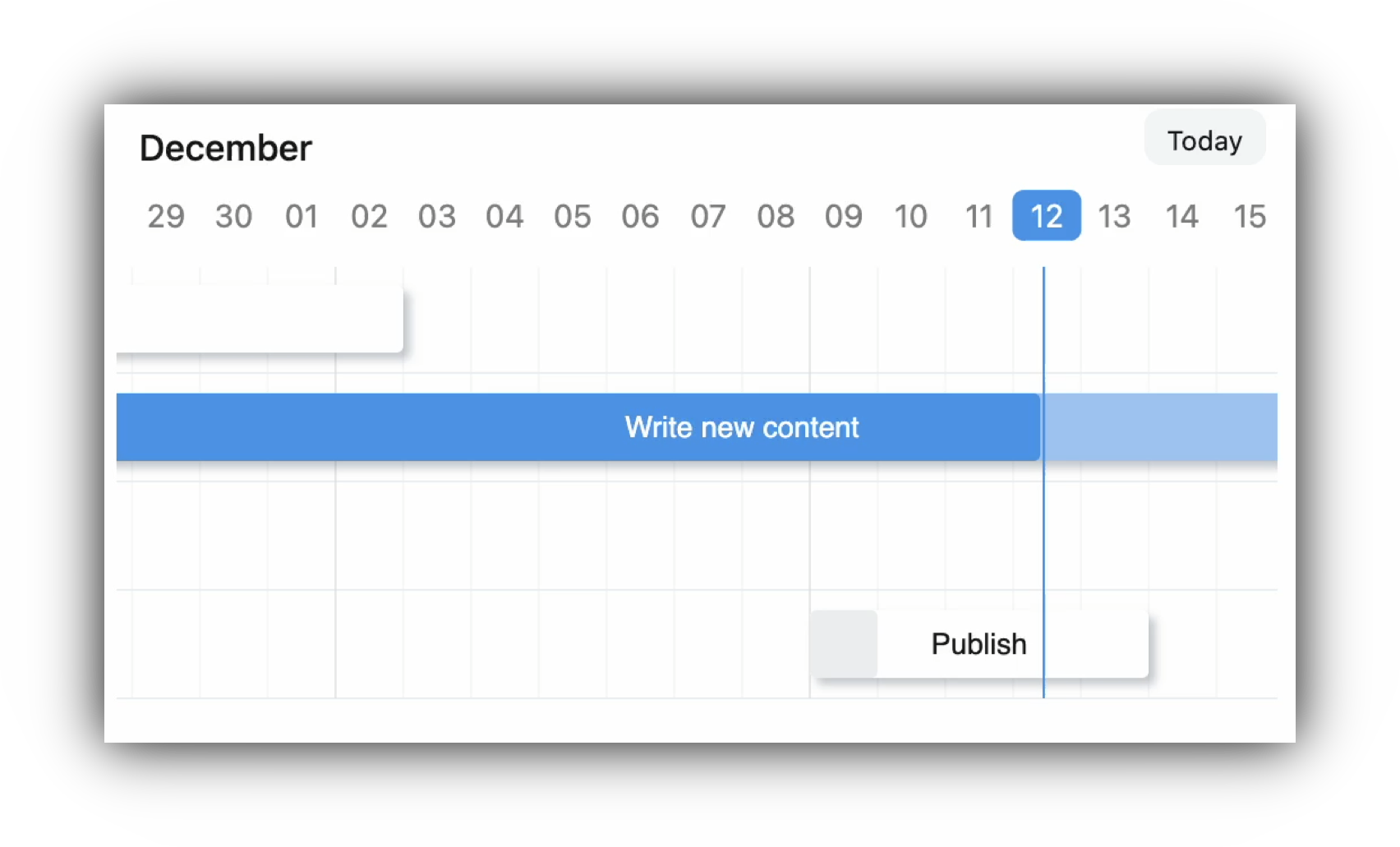

核心节奏:每日聚焦1个核心模块+落地实操,从基础调用到综合实战,全程基于本地环境,拒绝纯理论,每天1.5-2.5小时即可完成。

学习内容

快速了解LangChain核心价值、6大核心组件(模型/提示/链/记忆/文档处理/RAG)核心作用

本地环境二次校验,梳理已装依赖(langchain-core/community、模型依赖、FAISS)

核心目标:快速建立LangChain认知框架,确认本地环境可正常适配LangChain及相关依赖,为后续实操筑牢基础,无需深入复杂原理,重点在于"懂定位、能运行"。

快速了解LangChain核心价值、6大核心组件(模型/提示/链/记忆/文档处理/RAG)核心作用:

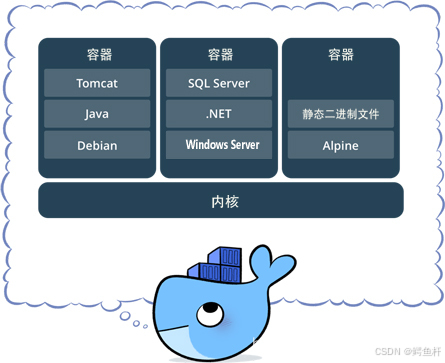

核心价值:LangChain并非独立大模型,而是"大模型连接器",核心作用是将大模型(API型/开源型)与外部资源(本地文档、数据库、工具等)串联,简化复杂AI应用的开发流程,避免重复编写基础调用代码,让开发者聚焦业务逻辑而非底层适配。

6大核心组件通俗解读(无需深入源码,先懂用途,结合实操重点展开)

1. 模型(Models)

LangChain的"核心动力源",相当于整个应用的"大脑",是所有生成式任务(问答、总结、创作)的基础——本质是LangChain通过统一接口,适配你本地已配置的各类大模型,无需单独为不同模型编写调用代码。

补充:后续重点学习2类模型的本地调用——API型模型(如OpenAI、智谱,需配置密钥,调用便捷、效果稳定)、开源型模型(如Llama3、Qwen,需本地部署,隐私性强、无调用成本),核心掌握模型参数配置(温度、最大生成长度等),且模型无法单独发挥作用,需与提示、链等组件配合,实现精准输出,本地实操中可直接通过LangChain封装的接口调用,无需关注底层实现。

2. 提示(Prompts)

LangChain的"指令导航器",相当于给"大脑"的"操作说明书",解决纯大模型"输出不可控"的痛点——纯大模型直接输入问题,易出现答非所问、格式混乱的情况,而提示组件通过模板化、标准化的指令,约束模型输出格式和内容方向。

补充:后续重点学习3类常用提示模板——PromptTemplate(通用文本模板,适合单一任务)、ChatPromptTemplate(对话式模板,适配多轮聊天场景)、FewShotPromptTemplate(小样本模板,给模型示例,提升输出准确性),提示模板可重复复用、灵活修改,本地实操中需结合具体任务(如文本总结、问答)编写,是优化模型输出的核心手段。

3. 链(Chains)

LangChain的"任务串联器",核心作用是将多个独立操作(如"提示模板调用+模型调用+结果处理")串联起来,实现多步任务自动化,解决纯大模型"只能单步执行"的痛点——纯大模型每次只能处理一个简单任务,而链可将多个简单任务组合,完成复杂需求(如"加载文档→总结文档→基于总结生成问答")。

补充:后续重点学习2类核心链——LLMChain(最基础的链,串联提示模板与模型,实现单步任务执行)、SimpleSequentialChain(顺序链,串联多个LLMChain,按步骤执行多步任务),链是组件融合的核心载体,后续记忆、RAG的实操,都需要与链结合,本地实操中可通过简单代码拼接链,实现多步任务自动化。

4. 记忆(Memory)

LangChain的核心组件之一,专门解决大模型"无长期记忆"的痛点——纯大模型每次调用都是独立会话,无法记住上一轮/多轮的聊天内容,而Memory会将历史对话信息(用户提问、模型回复)存储起来,每次新调用时,自动将历史记忆与当前提问拼接,传递给大模型,实现多轮连贯对话。

补充:后续会重点学习2种常用记忆类型——ConversationBufferMemory(简单存储全部历史对话,适合短对话,本地实操易上手)、ConversationSummaryMemory(自动总结历史对话,生成精简摘要,适合长对话,避免占用过多上下文窗口),记忆无法单独使用,必须与"链(Chains)"结合,才能实现多轮对话功能,本地实操中可直接调用内置方法,无需自己编写记忆存储逻辑。

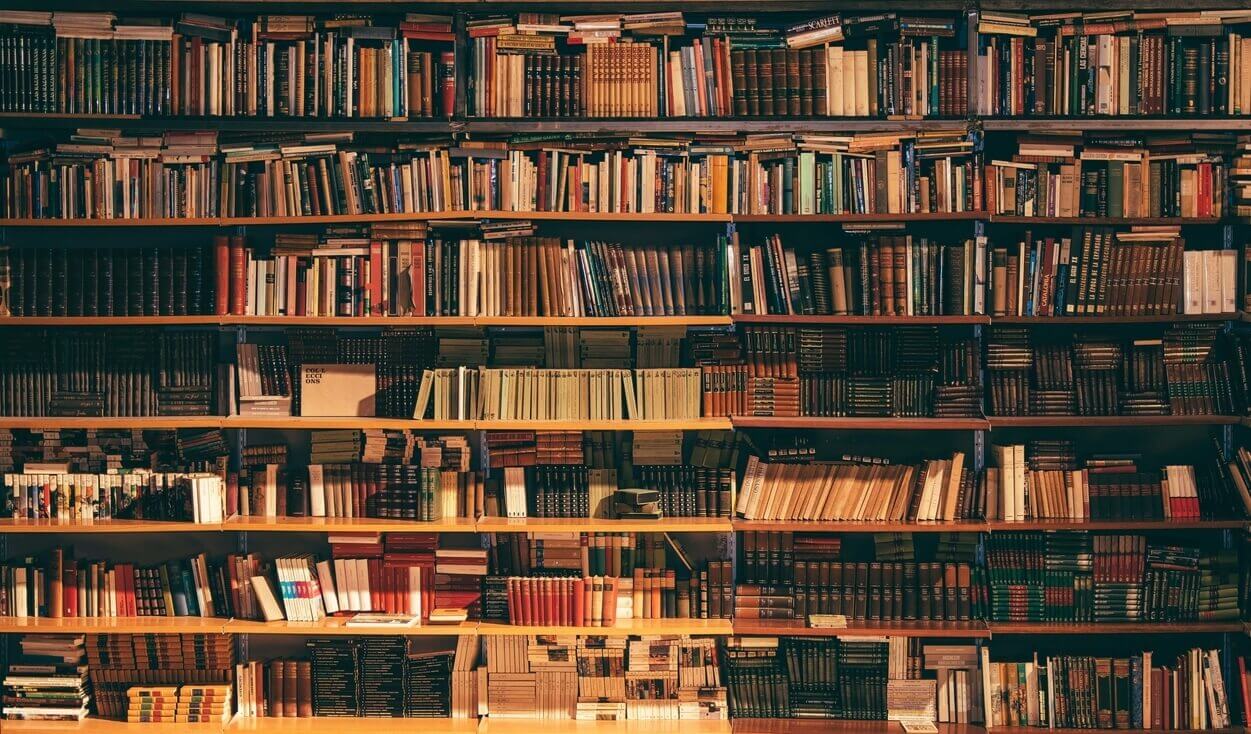

5. 文档处理(Document Loaders)

不仅支持加载本地TXT/PDF/Markdown等文档,还可适配云端、服务端文件链接(如阿里云OSS、腾讯云COS、GitHub RAW文件链接等),通过内置加载器获取远程文档内容,统一转化为模型可读取的格式,适配本地实操与后续远程文档拓展需求。

6. RAG(检索增强生成)

LangChain中最常用、最核心的应用场景之一,核心是"检索+生成"双向结合,彻底解决纯大模型的两大痛点——一是"胡言乱语"(模型训练数据有时间限制,且无法获取本地/私有文档信息,易生成错误内容),二是"内容无依据"(回答无法对应具体参考来源)。

补充:RAG的核心逻辑的是"先检索、后生成",简单来说,当用户提出一个问题时,不会直接让大模型回答,而是先从你本地(或云端)加载的文档中,检索出与问题最相关的片段(这一步依赖文档处理、向量化、FAISS向量库),再将"用户问题+检索到的相关文档片段"一起传递给大模型,让模型基于这些明确的参考内容,生成准确、有依据的回答。

后续重点学习:第4天的文档处理、向量化是RAG的前置基础,第5天会专门学习RAG完整流程(加载→分割→向量化→检索→生成)和核心配置,第6天综合实战会将RAG与记忆、提示工程结合,开发多轮对话RAG机器人,全程基于本地环境实操,无需复杂部署,重点掌握Retriever(检索器)配置、检索参数调优,就能实现本地文档精准问答。

2. 本地环境二次校验,梳理已装依赖(langchain-core/community、模型依赖、FAISS)

校验目的:避免后续实操中因依赖缺失、版本不兼容或配置错误导致代码运行失败,充分利用你已搭建好的本地环境。

具体校验步骤:

1. 查看已安装依赖

打开本地终端,输入命令:

# Windows

pip list | findstr langchain

# Mac/Linux

pip list | grep langchain

确认已安装langchain-core(核心组件)、langchain-community(社区扩展组件,包含文档加载、开源模型适配等)。

2. 校验模型依赖

分类型校验(根据你本地已搭建的模型选择对应步骤,无需两种都操作):

a. 若使用API型模型(如OpenAI、智谱AI、百度文心一言等)

检查核心依赖包是否安装:

# OpenAI

pip list | findstr openai # Windows

pip list | grep openai # Mac/Linux

# 千问AI

pip list | findstr dashscope # Windows

pip list | grep dashscope # Mac/Linux

# 智谱AI

pip list | findstr zhipuai # Windows

pip list | grep zhipuai # Mac/Linux

若未安装对应包,终端输入命令安装:

pip install openai # 安装OpenAI依赖

pip install dashscope # 安装千问AI依赖

pip install zhipuai # 安装智谱AI依赖

b. 若使用开源型模型(如Llama3、Qwen、ChatGLM等)

检查核心适配包是否安装:

# Llama系列

pip list | findstr llama-cpp-python # Windows

pip list | grep llama-cpp-python # Mac/Linux

# Qwen系列

pip list | findstr qwen-api # Windows

pip list | grep qwen-api # Mac/Linux

# ChatGLM系列

pip list | findstr transformers # 核心依赖

若未安装对应包,终端输入命令安装:

pip install llama-cpp-python # 安装Llama依赖

pip install qwen-api # 安装Qwen依赖

pip install transformers # 安装ChatGLM依赖

3. 校验FAISS依赖

输入命令:

# Windows

pip list | findstr faiss

# Mac/Linux

pip list | grep faiss

确认已安装FAISS(本地向量库,后续文档向量化、检索需用到)。

若未安装,补充安装命令如下(适配本地CPU环境,无需GPU,通用且易安装):

pip install faiss-cpu==1.7.4

通用提醒:安装依赖时,若出现报错(如编译失败),优先升级pip版本:

pip install --upgrade pip

4. 版本适配提醒

无需追求最新版本,确保langchain-core与langchain-community版本一致,且与你本地的Python版本(建议3.8及以上)、模型依赖版本、FAISS版本兼容。若出现报错,优先降级/升级对应依赖。