DeepSeek:视觉因果流编码器

📖标题:DeepSeek-OCR 2: Visual Causal Flow

🌐来源:arXiv, 2601.20552v1

🌟摘要

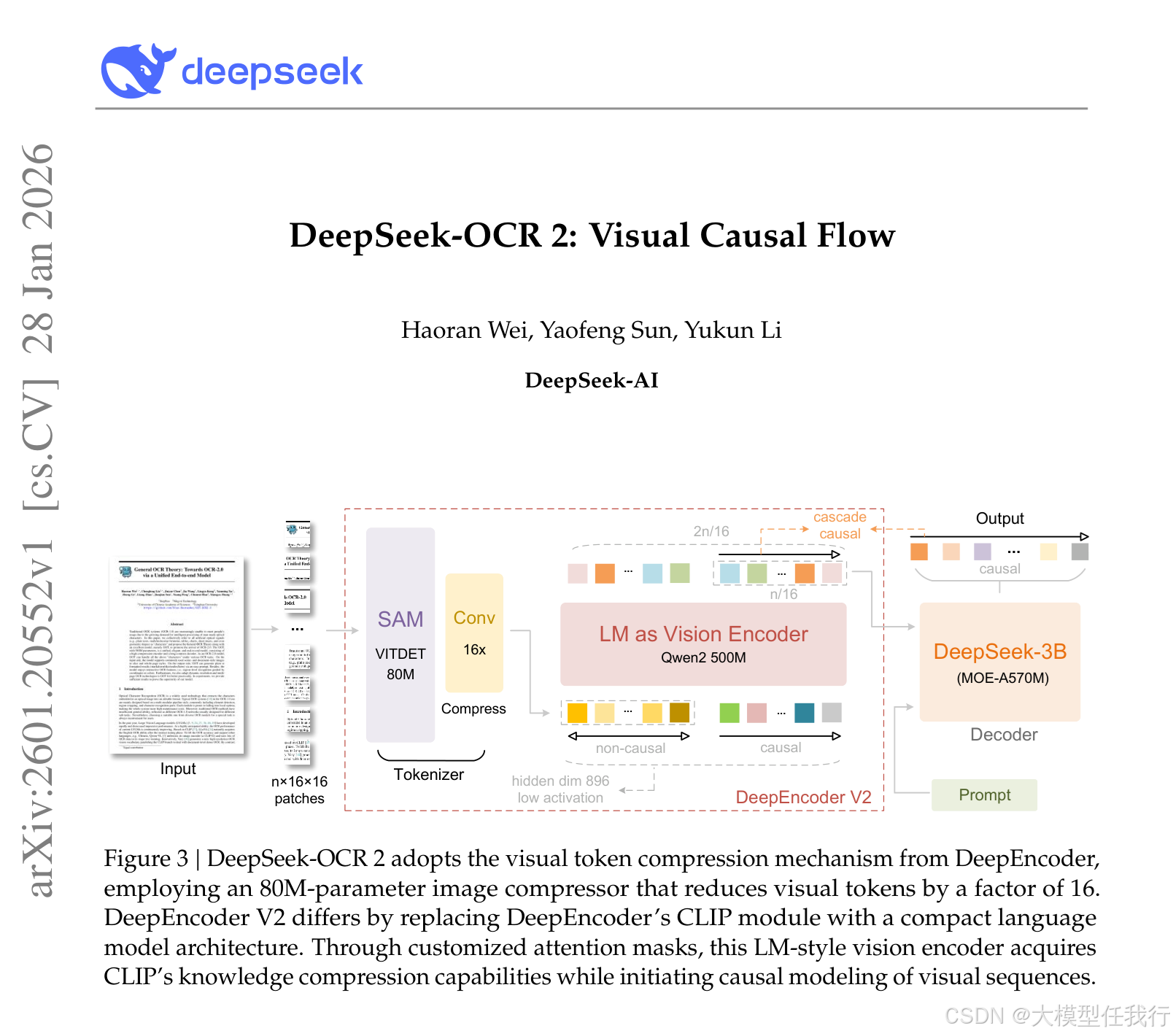

我们提出DeepSeek-OCR 2来研究一种新型编码器——DeepEncoder V2——的可行性,它能够根据图像语义学对视觉标记进行动态重新排序。传统的视觉语言模型(VLMs)在输入LLM时总是以严格的光栅扫描顺序(从左上角到右下角)处理视觉标记,并具有固定的位置编码。然而,这与人类视觉感知相矛盾,人类视觉感知遵循由固有逻辑结构驱动的灵活但语义连贯的扫描模式。特别是对于布局复杂的图像,人类视觉表现出因果关系的顺序处理。受这种认知机制的启发,DeepEncoder V2旨在赋予编码器因果推理能力,使其能够在基于LLM的内容解释之前智能地重新排序视觉标记。

这项工作探索了一种新颖的范式:是否可以通过两个级联的1D因果推理结构有效地实现2D图像理解,从而提供了一种具有实现真正2D推理潜力的新架构方法。代码和模型权重可在http://github.com/deepseek-ai/DeepSeek-OCR-2公开访问。

🛎️文章简介

🔸研究问题:能否通过让视觉编码器动态按语义因果关系重排序视觉token,实现更符合人类阅读逻辑的2D图像理解?

🔸主要贡献:论文提出DeepEncoder V2,首次将LLM式因果注意力机制引入视觉编码器,实现语义驱动的视觉token重排序,显著提升文档OCR中的阅读顺序建模与结构理解能力。

📝重点思路

🔸用轻量Qwen2-0.5B语言模型替代传统CLIP ViT,构建“语言模型即视觉编码器”架构,保留全局感知能力的同时引入因果建模潜力。

🔸设计因果流查询(causal flow queries):与视觉token等长的可学习query token后缀,通过定制化混合注意力掩码(左半部分双向、右半部分三角因果),使每个query仅关注所有视觉token及先前queries,实现渐进式重排序。

🔸采用多裁剪策略(1个全局视图+最多6个局部视图),统一配置query embedding,使输出token数在256–1120间可控,兼顾压缩率与细节捕获。

🔸仅将重排序后的因果flow tokens(而非原始视觉tokens)送入LLM解码器,形成“编码器语义重排→解码器自回归推理”的两级因果级联结构。

🔎分析总结

🔸在OmniDocBench v1.5上,DeepSeek-OCR 2以更少视觉token上限(1120 vs 1156)取得91.09%整体准确率,较基线提升3.73%,验证因果重排序的有效性。

🔸阅读顺序编辑距离(R-order Edit)从0.085降至0.057,且在9类文档中全面优于基线,证明其能更准确建模文本、公式、表格间的逻辑依赖关系。

🔸生产环境重复率显著下降(在线图像从6.25%→4.17%,PDF预处理从3.69%→2.88%),说明重排序提升了逻辑连贯性与输出稳定性。

🔸在公式识别(CDM↑6.17)、表格解析(TEDs↑3.05)等复杂布局任务上增益突出,印证因果流对非线性视觉结构建模的优势。

💡个人观点

论文核心创新在于打破“视觉token必须按空间栅格序输入LLM”的隐式假设,将人类视觉的因果扫描机制形式化为可学习的token重排序过程。

🧩附录