高级java每日一道面试题-2025年6月13日-多线程篇-ThreadPoolTaskExecutor内部使用LinkedBlockingQueue而非ArrayBlockingQueue的深度解析

ThreadPoolTaskExecutor内部使用LinkedBlockingQueue而非ArrayBlockingQueue的深度解析

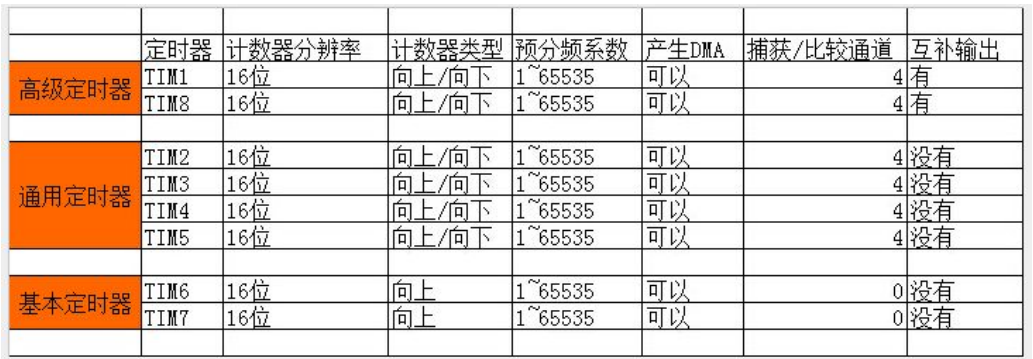

一、问题本质:LinkedBlockingQueue vs ArrayBlockingQueue

1.1 两种队列的核心差异对比

| 特性 | ArrayBlockingQueue | LinkedBlockingQueue |

|---|---|---|

| 底层数据结构 | 数组(固定大小) | 链表(动态扩展) |

| 容量限制 | 创建时必须指定固定容量 | 可以指定容量,默认Integer.MAX_VALUE |

| 锁机制 | 单锁(ReentrantLock) | 双锁分离(putLock + takeLock) |

| 内存分配 | 一次性分配连续内存 | 动态分配节点内存 |

| 吞吐量 | 相对较低 | 相对较高(双锁并发) |

| 内存使用 | 更节约(数组存储) | 每个节点额外开销 |

| 适用场景 | 固定大小队列,生产者-消费者均衡 | 高并发,大量生产消费操作 |

二、ThreadPoolTaskExecutor的选择考量

2.1 Spring的设计哲学

// Spring ThreadPoolTaskExecutor 内部实现分析

public class ThreadPoolTaskExecutor extends ExecutorConfigurationSupport

implements AsyncTaskExecutor, SchedulingTaskExecutor {

private final ThreadPoolExecutor threadPoolExecutor;

// 队列创建逻辑

protected BlockingQueue<Runnable> createQueue(int queueCapacity) {

if (queueCapacity > 0) {

// 使用LinkedBlockingQueue并指定容量

return new LinkedBlockingQueue<>(queueCapacity);

} else {

// 容量为0时使用SynchronousQueue

// 无容量时使用无界队列(Integer.MAX_VALUE)

return new LinkedBlockingQueue<>();

}

}

// 创建线程池

protected ExecutorService initializeExecutor(

ThreadFactory threadFactory, RejectedExecutionHandler rejectedExecutionHandler) {

// 使用LinkedBlockingQueue构建线程池

this.threadPoolExecutor = new ThreadPoolExecutor(

this.corePoolSize,

this.maxPoolSize,

this.keepAliveSeconds,

TimeUnit.SECONDS,

createQueue(this.queueCapacity), // 关键:使用LinkedBlockingQueue

threadFactory,

rejectedExecutionHandler

);

return this.threadPoolExecutor;

}

}

2.2 选择LinkedBlockingQueue的核心原因

原因1:更好的并发性能(双锁设计)

// ArrayBlockingQueue vs LinkedBlockingQueue 锁机制对比

// ArrayBlockingQueue - 单锁实现

public class ArrayBlockingQueue<E> extends AbstractQueue<E>

implements BlockingQueue<E>, java.io.Serializable {

final Object[] items;

final ReentrantLock lock; // 单锁:同时控制插入和取出

private final Condition notEmpty;

private final Condition notFull;

// 插入和取出操作共享同一把锁

public void put(E e) throws InterruptedException {

checkNotNull(e);

final ReentrantLock lock = this.lock;

lock.lockInterruptibly();

try {

while (count == items.length)

notFull.await();

enqueue(e);

} finally {

lock.unlock();

}

}

public E take() throws InterruptedException {

final ReentrantLock lock = this.lock;

lock.lockInterruptibly();

try {

while (count == 0)

notEmpty.await();

return dequeue();

} finally {

lock.unlock();

}

}

}

// LinkedBlockingQueue - 双锁分离实现

public class LinkedBlockingQueue<E> extends AbstractQueue<E>

implements BlockingQueue<E>, java.io.Serializable {

static class Node<E> {

E item;

Node<E> next;

Node(E x) { item = x; }

}

private final ReentrantLock takeLock = new ReentrantLock(); // 取锁

private final Condition notEmpty = takeLock.newCondition();

private final ReentrantLock putLock = new ReentrantLock(); // 插锁(分离)

private final Condition notFull = putLock.newCondition();

// 插入和取出操作使用不同的锁

public void put(E e) throws InterruptedException {

if (e == null) throw new NullPointerException();

int c = -1;

Node<E> node = new Node<E>(e);

final ReentrantLock putLock = this.putLock; // 只获取putLock

final AtomicInteger count = this.count;

putLock.lockInterruptibly();

try {

while (count.get() == capacity) {

notFull.await();

}

enqueue(node);

c = count.getAndIncrement();

if (c + 1 < capacity)

notFull.signal();

} finally {

putLock.unlock();

}

if (c == 0)

signalNotEmpty(); // 通知消费者

}

public E take() throws InterruptedException {

E x;

int c = -1;

final AtomicInteger count = this.count;

final ReentrantLock takeLock = this.takeLock; // 只获取takeLock

takeLock.lockInterruptibly();

try {

while (count.get() == 0) {

notEmpty.await();

}

x = dequeue();

c = count.getAndDecrement();

if (c > 1)

notEmpty.signal();

} finally {

takeLock.unlock();

}

if (c == capacity)

signalNotFull(); // 通知生产者

return x;

}

}

性能影响分析:

public class QueuePerformanceTest {

public static void main(String[] args) throws InterruptedException {

int capacity = 1000;

int producers = 4; // 4个生产者线程

int consumers = 4; // 4个消费者线程

// 测试ArrayBlockingQueue

BlockingQueue<Integer> arrayQueue = new ArrayBlockingQueue<>(capacity);

long arrayTime = testQueue(arrayQueue, producers, consumers);

// 测试LinkedBlockingQueue

BlockingQueue<Integer> linkedQueue = new LinkedBlockingQueue<>(capacity);

long linkedTime = testQueue(linkedQueue, producers, consumers);

System.out.println("ArrayBlockingQueue 耗时: " + arrayTime + "ms");

System.out.println("LinkedBlockingQueue 耗时: " + linkedTime + "ms");

System.out.println("性能差异: " +

((double)(arrayTime - linkedTime) / arrayTime * 100) + "%");

}

private static long testQueue(BlockingQueue<Integer> queue,

int producers, int consumers)

throws InterruptedException {

final int operations = 100000;

CountDownLatch latch = new CountDownLatch(producers + consumers);

long startTime = System.currentTimeMillis();

// 生产者线程

for (int i = 0; i < producers; i++) {

new Thread(() -> {

try {

for (int j = 0; j < operations / producers; j++) {

queue.put(j);

}

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

} finally {

latch.countDown();

}

}).start();

}

// 消费者线程

for (int i = 0; i < consumers; i++) {

new Thread(() -> {

try {

for (int j = 0; j < operations / consumers; j++) {

queue.take();

}

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

} finally {

latch.countDown();

}

}).start();

}

latch.await();

return System.currentTimeMillis() - startTime;

}

}

原因2:更灵活的容量管理

public class QueueCapacityAnalysis {

// ThreadPoolTaskExecutor的容量配置策略

public void analyzeCapacityStrategy() {

// 场景1:有界队列 - 控制内存使用

ThreadPoolTaskExecutor boundedExecutor = new ThreadPoolTaskExecutor();

boundedExecutor.setCorePoolSize(5);

boundedExecutor.setMaxPoolSize(10);

boundedExecutor.setQueueCapacity(100); // 限制队列长度

// 场景2:无界队列 - 避免任务拒绝

ThreadPoolTaskExecutor unboundedExecutor = new ThreadPoolTaskExecutor();

unboundedExecutor.setCorePoolSize(5);

unboundedExecutor.setMaxPoolSize(10);

// 不设置queueCapacity,默认使用LinkedBlockingQueue的无界版本

// 队列容量为Integer.MAX_VALUE

// 场景3:直接交接 - 无缓冲

ThreadPoolTaskExecutor directExecutor = new ThreadPoolTaskExecutor();

directExecutor.setCorePoolSize(5);

directExecutor.setMaxPoolSize(10);

directExecutor.setQueueCapacity(0); // 使用SynchronousQueue

System.out.println("LinkedBlockingQueue的优势:");

System.out.println("1. 支持有界和无界两种模式");

System.out.println("2. 动态调整,无需预分配大数组");

System.out.println("3. 避免ArrayBlockingQueue的固定内存占用");

}

// 内存使用对比

public void memoryUsageComparison() {

// ArrayBlockingQueue - 预分配内存

BlockingQueue<Object> arrayQueue = new ArrayBlockingQueue<>(10000);

// 立即分配10000个Object引用的数组空间

// LinkedBlockingQueue - 按需分配

BlockingQueue<Object> linkedQueue = new LinkedBlockingQueue<>(10000);

// 只分配头尾节点和容量计数器,不预分配元素空间

System.out.println("启动内存对比:");

System.out.println("ArrayBlockingQueue: 立即占用固定内存");

System.out.println("LinkedBlockingQueue: 按需增长,启动时内存占用小");

}

}

原因3:线程池工作模式的适配性

public class ThreadPoolBehaviorAnalysis {

public void analyzeThreadPoolBehavior() {

// 线程池的四种工作队列策略

analyzeDifferentQueues();

}

private void analyzeDifferentQueues() {

System.out.println("=== 线程池队列策略分析 ===");

// 1. 无界LinkedBlockingQueue(默认)

System.out.println("

1. 无界LinkedBlockingQueue:");

System.out.println("- 线程数维持在corePoolSize");

System.out.println("- 队列永远不会满,maxPoolSize无效");

System.out.println("- 适合任务量可预测,避免任务丢弃");

System.out.println("- 风险:可能内存溢出");

// 2. 有界LinkedBlockingQueue

System.out.println("

2. 有界LinkedBlockingQueue:");

System.out.println("- 队列满时创建新线程(直到maxPoolSize)");

System.out.println("- 线程数和队列形成弹性缓冲");

System.out.println("- 适合突发流量场景");

// 3. ArrayBlockingQueue替代方案分析

System.out.println("

3. ArrayBlockingQueue作为替代:");

System.out.println("- 性能瓶颈:单锁导致生产消费互斥");

System.out.println("- 内存浪费:预分配可能用不到的容量");

System.out.println("- 不灵活:无法动态调整队列行为");

// 4. SynchronousQueue(容量为0)

System.out.println("

4. SynchronousQueue(queueCapacity=0):");

System.out.println("- 无缓冲,直接交接");

System.out.println("- 适合短任务、高响应场景");

System.out.println("- 容易触发拒绝策略");

}

// 实际工作模式演示

public void demonstrateWorkflow() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setCorePoolSize(2);

executor.setMaxPoolSize(4);

executor.setQueueCapacity(10);

executor.initialize();

System.out.println("任务提交顺序:");

// 模拟任务提交

for (int i = 1; i <= 20; i++) {

final int taskId = i;

executor.execute(() -> {

System.out.println("执行任务 " + taskId +

",线程:" + Thread.currentThread().getName() +

",队列大小:" + executor.getThreadPoolExecutor().getQueue().size());

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

});

// 观察线程池状态变化

if (i == 1) System.out.println("第一个任务:创建核心线程");

if (i == 3) System.out.println("第三个任务:进入队列");

if (i == 13) System.out.println("第十三个任务:队列满,创建新线程");

if (i == 17) System.out.println("第十七个任务:达到maxPoolSize");

}

}

}

三、深度源码分析

3.1 LinkedBlockingQueue的双锁实现细节

// LinkedBlockingQueue的原子计数器实现

public class LinkedBlockingQueue<E> extends AbstractQueue<E>

implements BlockingQueue<E>, java.io.Serializable {

// 原子计数器,避免同时获取两把锁

private final AtomicInteger count = new AtomicInteger();

// 节点类

static class Node<E> {

E item;

Node<E> next;

Node(E x) { item = x; }

}

// 队列头尾

private transient Node<E> head;

private transient Node<E> last;

// 插入操作优化

private void enqueue(Node<E> node) {

// 直接将node链接到last后面

last = last.next = node;

}

// 取出操作优化

private E dequeue() {

Node<E> h = head;

Node<E> first = h.next;

h.next = h; // 帮助GC

head = first;

E x = first.item;

first.item = null;

return x;

}

// 信号传递机制

private void signalNotEmpty() {

final ReentrantLock takeLock = this.takeLock;

takeLock.lock();

try {

notEmpty.signal();

} finally {

takeLock.unlock();

}

}

private void signalNotFull() {

final ReentrantLock putLock = this.putLock;

putLock.lock();

try {

notFull.signal();

} finally {

putLock.unlock();

}

}

}

// ArrayBlockingQueue的公平性控制

public class ArrayBlockingQueue<E> extends AbstractQueue<E>

implements BlockingQueue<E>, java.io.Serializable {

// 可选择公平锁或非公平锁

public ArrayBlockingQueue(int capacity, boolean fair) {

if (capacity <= 0)

throw new IllegalArgumentException();

this.items = new Object[capacity];

lock = new ReentrantLock(fair); // 公平性选项

notEmpty = lock.newCondition();

notFull = lock.newCondition();

}

}

3.2 ThreadPoolTaskExecutor的性能调优策略

// 线程池队列的监控和调优

public class ThreadPoolOptimization {

public void monitorAndOptimize(ThreadPoolTaskExecutor executor) {

ThreadPoolExecutor threadPool = executor.getThreadPoolExecutor();

// 监控指标

int corePoolSize = threadPool.getCorePoolSize();

int maxPoolSize = threadPool.getMaximumPoolSize();

int activeThreads = threadPool.getActiveCount();

long completedTasks = threadPool.getCompletedTaskCount();

int queueSize = threadPool.getQueue().size();

// 动态调优策略

if (queueSize > 100 && activeThreads < maxPoolSize) {

// 队列积压,但还有扩容空间

System.out.println("建议:增加工作线程处理积压任务");

}

if (queueSize == 0 && activeThreads > corePoolSize) {

// 队列空闲,有多余线程

System.out.println("建议:空闲线程将在keepAliveTime后回收");

}

// 使用LinkedBlockingQueue特有的监控

if (threadPool.getQueue() instanceof LinkedBlockingQueue) {

LinkedBlockingQueue<?> queue = (LinkedBlockingQueue<?>) threadPool.getQueue();

int remainingCapacity = queue.remainingCapacity();

System.out.println("队列剩余容量:" + remainingCapacity);

// 动态调整队列容量(如果需要)

adjustQueueCapacityDynamically(queue, remainingCapacity);

}

}

private void adjustQueueCapacityDynamically(LinkedBlockingQueue<?> queue,

int remainingCapacity) {

// 实际中LinkedBlockingQueue容量不可动态调整

// 这里展示的是设计思路

if (remainingCapacity < 10) {

System.out.println("警告:队列即将满,考虑增加maxPoolSize或优化任务处理");

}

}

// 队列选择建议

public void queueSelectionAdvice() {

System.out.println("

=== 队列选择指导 ===");

// 场景1:CPU密集型任务

System.out.println("

场景1:CPU密集型任务");

System.out.println("建议:使用有界LinkedBlockingQueue");

System.out.println("理由:避免任务无限堆积,保护系统");

// 场景2:IO密集型任务

System.out.println("

场景2:IO密集型任务");

System.out.println("建议:使用无界LinkedBlockingQueue或增大队列容量");

System.out.println("理由:充分利用线程等待IO的时间");

// 场景3:混合型任务

System.out.println("

场景3:混合型任务(生产消费不平衡)");

System.out.println("建议:使用LinkedBlockingQueue + 合理的拒绝策略");

System.out.println("理由:双锁设计减少生产消费冲突");

// 场景4:实时系统

System.out.println("

场景4:实时响应系统");

System.out.println("建议:使用SynchronousQueue或小容量ArrayBlockingQueue");

System.out.println("理由:快速响应,避免任务排队");

}

}

四、面试深度解析

4.1 核心面试问题

Q1:为什么ThreadPoolTaskExecutor默认使用LinkedBlockingQueue而不是ArrayBlockingQueue?

参考答案:

ThreadPoolTaskExecutor选择LinkedBlockingQueue基于以下几个关键考量:

1. **并发性能优势**:

- LinkedBlockingQueue采用双锁分离设计(putLock和takeLock)

- 生产者和消费者可以并发操作,减少锁竞争

- ArrayBlockingQueue使用单锁,生产消费操作互斥

2. **灵活性更高**:

- LinkedBlockingQueue支持有界和无界两种模式

- 无界队列(默认)适合任务量不可预测的场景

- 有界队列可以防止内存溢出,同时保持弹性

3. **内存使用效率**:

- LinkedBlockingQueue按需分配节点内存

- ArrayBlockingQueue预分配固定大小的数组,可能造成内存浪费

- 对于线程池这种动态场景,按需分配更合理

4. **与线程池工作模式匹配**:

- 线程池的核心-最大线程数+队列形成三级缓冲

- LinkedBlockingQueue的双锁设计与线程池的多线程特性更契合

- 支持更平滑的任务调度和线程扩展

5. **历史兼容性**:

- Java线程池(ThreadPoolExecutor)默认使用LinkedBlockingQueue

- Spring保持与Java标准库的一致性

Q2:在什么情况下应该使用ArrayBlockingQueue?

参考答案:

虽然ThreadPoolTaskExecutor默认使用LinkedBlockingQueue,但在以下场景ArrayBlockingQueue可能更合适:

1. **内存敏感环境**:

- ArrayBlockingQueue的数组结构更紧凑,内存开销更小

- 每个元素只有对象引用,无节点额外开销

2. **严格的FIFO顺序要求**:

- ArrayBlockingQueue的数组实现提供更严格的数据局部性

- 对于需要严格顺序处理且容量固定的场景更合适

3. **可预测的固定容量**:

- 任务量稳定,队列大小可以精确预估

- 避免LinkedBlockingQueue动态分配的开销

4. **公平性控制需求**:

- ArrayBlockingQueue支持公平锁选项

- 可以防止线程饥饿,保证公平访问

5. **批量操作优化**:

- ArrayBlockingQueue的连续内存布局有利于批量操作

- 某些硬件架构上数组访问性能更好

使用示例:

```java

// 自定义使用ArrayBlockingQueue的线程池

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor() {

@Override

protected BlockingQueue createQueue(int queueCapacity) {

// 使用ArrayBlockingQueue并指定公平性

return new ArrayBlockingQueue<>(queueCapacity, true);

}

};

但需要注意:在大多数Spring应用场景中,LinkedBlockingQueue的综合优势更明显。

**Q3:LinkedBlockingQueue的无界队列有什么风险?如何避免?**

**参考答案:**

无界LinkedBlockingQueue(默认Integer.MAX_VALUE)的风险:

-

内存溢出风险:

- 任务生产速度持续高于消费速度时,队列无限增长

- 最终导致OutOfMemoryError

-

响应时间恶化:

- 任务在队列中长时间等待

- 系统吞吐量看似正常,但用户感知延迟高

-

资源耗尽连锁反应:

- 内存压力导致GC频繁,进一步降低处理能力

- 可能影响整个应用稳定性

防范措施:

- 设置合理的队列容量:

executor.setQueueCapacity(1000); // 根据系统负载设置

- 监控队列深度:

// 定期监控

int queueSize = executor.getThreadPoolExecutor().getQueue().size();

if (queueSize > threshold) {

// 触发告警或限流

}

- 使用合适的拒绝策略:

executor.setRejectedExecutionHandler(new ThreadPoolExecutor.CallerRunsPolicy());

// 或自定义拒绝策略

-

动态线程池调整:

- 根据队列深度动态调整核心/最大线程数

- 实现弹性伸缩

-

任务优先级和过期机制:

// 使用优先级队列或支持过期的队列

PriorityBlockingQueue<Runnable> queue = new PriorityBlockingQueue<>();

- 生产端限流:

- 在任务提交层进行限流控制

- 使用RateLimiter或Semaphore控制提交速率

### 4.2 性能调优实战

```java

// 线程池调优配置示例

@Configuration

public class ThreadPoolConfiguration {

@Bean("ioIntensiveExecutor")

public ThreadPoolTaskExecutor ioIntensiveExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

// IO密集型任务配置

executor.setCorePoolSize(Runtime.getRuntime().availableProcessors() * 2);

executor.setMaxPoolSize(Runtime.getRuntime().availableProcessors() * 4);

executor.setQueueCapacity(1000); // 合理的有界队列

executor.setKeepAliveSeconds(60);

executor.setThreadNamePrefix("io-executor-");

// 使用CallerRunsPolicy避免任务丢失

executor.setRejectedExecutionHandler(new ThreadPoolExecutor.CallerRunsPolicy());

executor.initialize();

return executor;

}

@Bean("cpuIntensiveExecutor")

public ThreadPoolTaskExecutor cpuIntensiveExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

// CPU密集型任务配置

executor.setCorePoolSize(Runtime.getRuntime().availableProcessors());

executor.setMaxPoolSize(Runtime.getRuntime().availableProcessors());

executor.setQueueCapacity(100); // 较小的队列,快速拒绝

executor.setThreadNamePrefix("cpu-executor-");

// 使用AbortPolicy,配合监控快速发现问题

executor.setRejectedExecutionHandler(new ThreadPoolExecutor.AbortPolicy());

executor.initialize();

return executor;

}

@Bean("batchExecutor")

public ThreadPoolTaskExecutor batchExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

// 批处理任务配置

executor.setCorePoolSize(5);

executor.setMaxPoolSize(10);

executor.setQueueCapacity(Integer.MAX_VALUE); // 无界队列,避免任务丢失

executor.setThreadNamePrefix("batch-executor-");

// 重要:监控队列深度,防止内存溢出

monitorQueueDepth(executor);

executor.initialize();

return executor;

}

private void monitorQueueDepth(ThreadPoolTaskExecutor executor) {

ScheduledExecutorService monitor = Executors.newSingleThreadScheduledExecutor();

monitor.scheduleAtFixedRate(() -> {

int queueSize = executor.getThreadPoolExecutor().getQueue().size();

if (queueSize > 10000) {

// 触发告警

System.err.println("警告:批处理队列深度过高:" + queueSize);

}

}, 1, 1, TimeUnit.MINUTES);

}

}

4.3 替代方案考虑

// 其他队列选择的分析

public class AlternativeQueueAnalysis {

public void analyzeOtherQueues() {

System.out.println("=== 其他阻塞队列分析 ===");

// 1. PriorityBlockingQueue

System.out.println("

1. PriorityBlockingQueue:");

System.out.println("- 支持优先级排序");

System.out.println("- 适合任务有不同优先级的场景");

System.out.println("- 但线程池的FIFO语义被破坏");

// 2. DelayQueue

System.out.println("

2. DelayQueue:");

System.out.println("- 支持延迟执行");

System.out.println("- 适合定时任务调度");

System.out.println("- 不适用于普通任务队列");

// 3. SynchronousQueue

System.out.println("

3. SynchronousQueue:");

System.out.println("- 无缓冲,直接交接");

System.out.println("- 高吞吐,但容易触发拒绝策略");

System.out.println("- 适合短任务、高并发场景");

// 4. LinkedTransferQueue(JDK7+)

System.out.println("

4. LinkedTransferQueue:");

System.out.println("- 结合了SynchronousQueue和LinkedBlockingQueue的优点");

System.out.println("- 支持更高效的生产者-消费者交互");

System.out.println("- 但在线程池中的使用不如LinkedBlockingQueue成熟");

}

// 自定义队列实现

static class ResizableLinkedBlockingQueue<E> extends LinkedBlockingQueue<E> {

private volatile int capacity;

public ResizableLinkedBlockingQueue(int capacity) {

super(capacity);

this.capacity = capacity;

}

public synchronized void setCapacity(int newCapacity) {

if (newCapacity < size()) {

throw new IllegalArgumentException(

"New capacity cannot be less than current size");

}

this.capacity = newCapacity;

// 通知等待的生产者

if (newCapacity > size()) {

signalNotFull();

}

}

@Override

public int remainingCapacity() {

return capacity - size();

}

}

}

五、总结与最佳实践

5.1 核心要点总结

-

设计选择合理性:

- LinkedBlockingQueue的双锁设计更适合高并发线程池场景

- 动态内存分配比固定数组更适应不确定的任务负载

- 无界队列提供弹性,有界队列提供保护

-

性能权衡:

- 高并发下,LinkedBlockingQueue的吞吐量优势明显

- 内存敏感场景,ArrayBlockingQueue可能更合适

- 实际选择需根据具体业务场景

-

监控与调优:

- 必须监控队列深度,防止内存溢出

- 根据任务类型(CPU/IO密集型)调整配置

- 使用合适的拒绝策略

5.2 最佳实践建议

public class ThreadPoolBestPractices {

public void configureThreadPool() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

// 1. 根据任务类型设置线程数

if (isIoIntensive()) {

executor.setCorePoolSize(cpuCores * 2);

executor.setMaxPoolSize(cpuCores * 4);

} else {

executor.setCorePoolSize(cpuCores);

executor.setMaxPoolSize(cpuCores);

}

// 2. 设置合理的队列容量

// 经验值:队列容量 = 核心线程数 * 每个线程处理能力 * 可接受延迟时间

int queueCapacity = calculateOptimalQueueSize();

executor.setQueueCapacity(queueCapacity);

// 3. 设置合适的拒绝策略

executor.setRejectedExecutionHandler(

new ThreadPoolExecutor.CallerRunsPolicy() // 生产环境常用

);

// 4. 设置线程名前缀,便于监控

executor.setThreadNamePrefix("app-task-");

// 5. 启用监控

enableMonitoring(executor);

executor.initialize();

}

private int calculateOptimalQueueSize() {

// 根据业务特点计算

// 示例:假设每个任务平均处理时间100ms,可接受延迟2秒

// 队列容量 = 线程数 * (可接受延迟 / 处理时间)

int threads = Runtime.getRuntime().availableProcessors();

return threads * (2000 / 100); // 约20倍线程数

}

private void enableMonitoring(ThreadPoolTaskExecutor executor) {

ScheduledExecutorService monitor = Executors.newSingleThreadScheduledExecutor();

monitor.scheduleAtFixedRate(() -> {

ThreadPoolExecutor pool = executor.getThreadPoolExecutor();

System.out.printf("线程池状态: 活跃=%d, 核心=%d, 最大=%d, 队列=%d/%d, 完成=%d%n",

pool.getActiveCount(),

pool.getCorePoolSize(),

pool.getMaximumPoolSize(),

pool.getQueue().size(),

executor.getQueueCapacity(),

pool.getCompletedTaskCount());

}, 1, 5, TimeUnit.SECONDS);

}

}

通过深入理解ThreadPoolTaskExecutor选择LinkedBlockingQueue的原因,开发者可以更好地配置和调优线程池,构建高性能、稳定的并发处理系统。